Wczoraj miałem ciekawą rozmowę z żoną odnośnie dezinformacji na ścieku rogalowym. Normalnie nie wchodzi na główną z wiadomych powodów ale rzucił się jej w oczy artykuł.

"Polska będzie dopłacać do emerytur z Hindusów?", źródło gazeta prawna a nie blogPrawdziwyPatriota69.ru więc zainteresował ją temat i z artykułu można się dowiedzieć że jeśli ktoś przepracuje w Indiach np 20 lat, a w Polsce zapłaci jedną(!) składkę to już ma prawo do wypłacania polskiej emerytury, bo okresy będą się sumować.

Moja pierwsza myśl "WTF" ale brzmiało to zbyt bzdurnie, więc zadałem jej pytanie gdzie to znalazła i okazało się że na głównej wyk0pu (z bocznego paska więc nie z aktualności).

No i powiedziałem jej że ma 2 drogi, albo zakładasz w ciemno że to nieprawda lub manipulacja i trafisz z dokładnością 98% (albo i więcej xD) albo przeczytamy umowę którą sejm ratyfikował i się dowiemy co tam tak naprawdę jest.

No i cholera wybrała drugie więc, że to był mój pomysł to trzeba było czytać xD

Co się okazało?

Że artykuł to byłą totalna bzdura zmanipulowana przez autora w świadomy sposób, bo nawet były zapisy wprost przeczące temu co autor pisał w artykule (NO ALE ON PRZECIEŻ ZADAŁ PYTANIE A NIE STWIERDZIŁ HEHE). Nawet upraszczając to ciężko dojść do takich wniosków.

(Skracając, każdy kraj ma płacić emeryturę, tylko za okres w którym on przepracował)

Na koniec jeszcze dla pewności zapytaliśmy GPT czy da się to jakoś inaczej rozumieć i wynik był ten sam, nawet wskazywał na te same punkty xdd

Tak więc jeśli ktoś się zastanawiał nad wiarygodnością tego portalu (Gazety prawnej, co do wykopu nie ma wątpliwości)

Artykuł: https://www.gazetaprawna.pl/praca/artykuly/9783940,doplacimy-do-emerytur-dla-hindusow-ta-umowa-juz-czeka.html

Umowa: https://www.gov.pl/web/premier/projekt-ustawy-o-ratyfikacji-umowy-miedzy-rzeczapospolita-polska-a-republika-indii-o-zabezpieczeniu-spolecznym-podpisanej-w-warszawie-dnia-25-listopada-2024-r

A gdyby ktoś chciał dostać raka od komentarzy: https://wykop.pl/link/7695441/doplacimy-do-emerytur-dla-hindusow-ta-umowa-juz-czeka

#wykop #dezinformacja #fakenews

#dezinformacja

@Czokowoko mój kolega jest strasznym leniem i poprosił żebym zapytał czy nie wkleisz fragmentu dotyczącego wpisu

@Czokowoko lepiej:

Dwa miesiące temu wyjaśniłem osobę na kierowniczym stanowisku niższego szczebla która bez mrugnięcia oknem powiedziała:

Ukrainiec przepracuje w Polsce rok i dostanie emeryturę. Zapytana skąd to wie odpowiedziała że z HR.

Myślałem że mi oczy wyjdą z orbit. Oczywiście HR w życiu by czegoś takiego nie powiedział (mamy naprawdę ogarnięte babki) więc w ciągu kilku sekund przytoczyłem jej treść ustawy o ubezpieczeniach społecznych.

Odwróciła się na pięcie i wyszła.

Na jej profilu na FB znajdziesz masę wrzutek "patriotycznych" kotwic powstańczych, husarii itp

Zaloguj się aby komentować

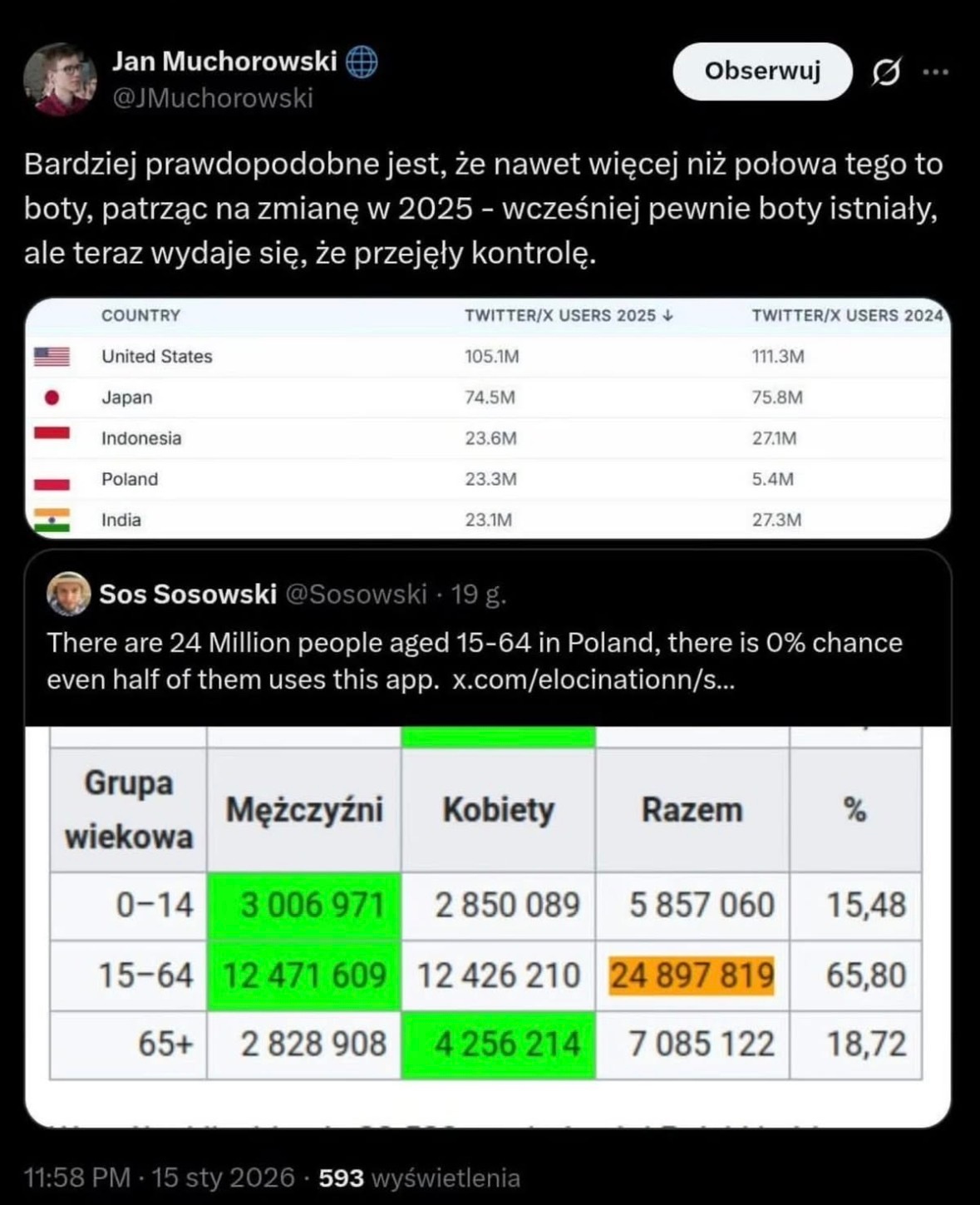

Był wykop to teraz jeszcze #twitter

Liczba kont na Twiterze pochodzacych z Polski wzrosła w rok o 18 milionów (z 5 na 23 milionow).

A pózniej te 18 milionow botow mowi ci co masz myslec. ( ͡° ͜ʖ ͡°)

#ai #boty #ciekawostki #dezinformacja #fakenews #internet

Tam zawsze było dużo botów. Pewnie tylko zmieniły kraj pochodzenia. Szefostwo albo sobie z tym nie radziło, albo było im na rękę. Jedyny moment walki to chyba bezpośrednio przez przejęciem przez Elona, ale Muskowi nagle zaczęły się podobać, więc obecnie jest jak jest :)

@4pietrowydrapaczchmur każdy ci mówi, co masz myśleć. nie tylko boty. influencerzy, politycy, nawet koledzy, mama i tata. dlatego tak ważna jest umiejętność krytycznego myślenia.

Zaloguj się aby komentować

![Blue Monday to jedna z „teorii zombie” - choć nauka ją „zabiła”, dalej trwa w pamięci [WYWIAD]](https://cdn.hejto.pl/uploads/posts/images/250x250/386b8ce9a9d9ffb866c4c44e2eb834c1.jpg)

Blue Monday to jedna z „teorii zombie” - choć nauka ją „zabiła”, dalej trwa w pamięci [WYWIAD]

Na przykładzie Blue Monday - czyli rzekomo „najbardziej dołującego dnia roku”, którego istnienie jest fake newsem - prof. Michał Białek z Uniwersytetu Wrocławskiego wyjaśnia, jak działa metoda naukowa, a więc jakimi narzędziami dysponuje nauka, aby potwierdzić lub obalić jakieś tezy. Blue Monday...

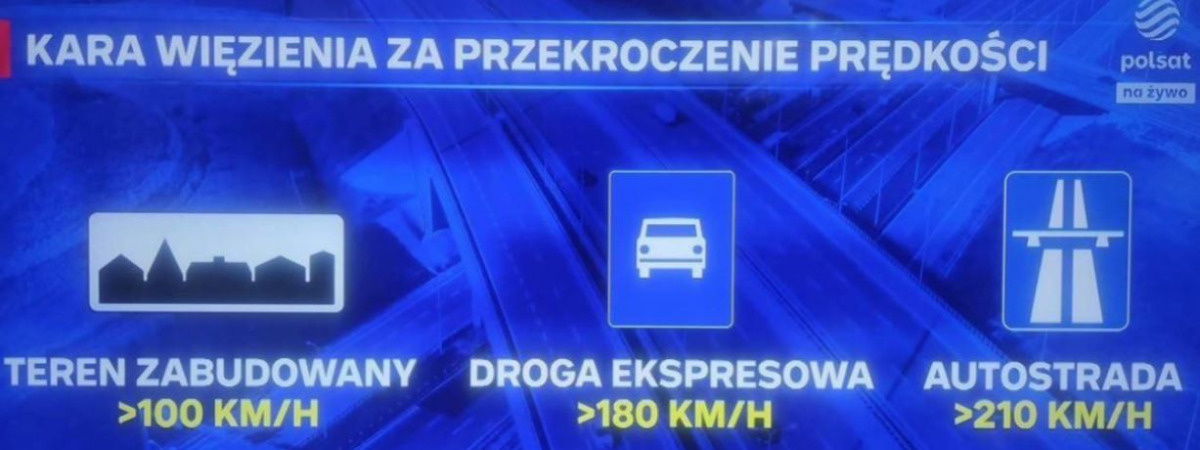

Na mikroblogu wykopu z wieloma plusami jest wprowadzająca w błąd infografika. Dlatego za ministerstwem sprawiedliwości podaje:

interpretacje sugerujące karanie (więzieniem) za samo przekroczenie prędkości są błędne.

przestępstwo może zostać popełnione wyłącznie w przypadku łącznego spełnienia trzech przesłanek:

-

prowadzenia pojazdu z rażąco nadmierną prędkością,

-

rażącego naruszenia innych przepisów o ruchu drogowym,

-

narażenia innego człowieka na bezpośrednie niebezpieczeństwo utraty życia lub uszczerbku na zdrowiu.

#prawo #prawojazdy #dezinformacja #wykop

Czyli dopóki śmignę 120 km/h przez miasto, ale na zielonym, sygnalizując zmiany pasa i będzie powiedzmy trzecia w nocy, więc żywej duszy w pobliżu, to w sumie elo mordo, masz tu pouczenie? Fajne te nowe przepisy, takie egzekwowalne.

Generalnie to mamy cała masę różnych przepisów, na które prawie każdy ma wywalone jajca bo do tego właśnie prowadzi legislacyjna sraczka. Dodatkowo jeszcze brak ich egzekwowania bo patroli jest mało.

Problem z przekraczaniem prędkości? Jest na to sposób, na który technologicznie jesteśmy gotowi (ale pewnie nie obywatelsko...). Zalegalizować jakiś model wideorejestratora z pomiarem prędkości, GPS, GSM i dopuścić do ich używania osoby prywatne. Takie urządzenie mógłby kupić czy wydzierżawić sobie każdy i zamontować we własnym aucie. Każde zarejestrowane przekroczenie o ileś tam kilometrów (20, 30 czy może nawet i 50...) byłoby automatycznie wysyłane na serwer do analizy i wystawienia mandatu. Żeby nie było za różowo to sprawdzana byłby też prędkość nagrywającego, żeby nie było sytuacji, że ktoś sobie zapierdziela lewym na autostradzie 200 i nagrywa tych co jadą 180. No i wisienka na torcie - za każdy mandat użytkownik takiego urządzenia dostawałby prowizję. Tak, oczywiście, już słyszę jak się niektórzy zapowietrzają "to donosicielstwo, esbeckie metody, literalnie komunis itp." A wg mnie to społeczeństwo obywatelskie. Skoro żadne kary nie są w stanie rozwiązać problemu, służby nie mają ludzi żeby z tym sobie poradzić to sami obywatele powinni przyczyniać się do poprawy sytuacji. Czym to by się w zasadzie różniło od zatrzymania najebanego kierowcy jadącego zygzakiem, zabrania mu kluczyków i wezwania policji?

@Rozkmin ta grafika (oby tylko, a nie przepis) też z d⁎⁎y, bo przecież ograniczenia prędkości w mieście też mogą być różne. Rozumiem przesłankę o spełnieniu "trzech wymagań" ale mam nadzieję że chodzi o przekroczenie prędkości o X km, a nie "jechanie powyżej 100km na godzinę", bo to jest po prostu głupie xD

Zaloguj się aby komentować

Estoński thinktank ujawniający ruską propagandę o dezinformacji w Polsce

Za Fakenews.pl: Julia Dobrowolska, doktorantka nauk społecznych UW, oraz fact checkerka napisała artykuł dla estońskiego portalu propastop o rosyjskiej dezinformacji w Polsce, oraz jej wpływie na społeczeństwo. #propaganda #dezinformacja #rosja #polska #fakenews

od 17 min. dobry kawałek odnoście naszych fanatyków.

https://youtu.be/8YJuvZR7iHc?si=mO3cupgH3j2yP8O-

#geopolityka #wojnahybrydowa #dezinformacja

Zaloguj się aby komentować

Specjalista od dezinformacji: Spełnia się marzenie Putina. Bez oddania jednego wystrzału

Kwestionowanie NATO przez Polaków to jest mokry sen Kremla. Zaraz stanie się rzeczywistością — mówi w rozmowie z Onetem Michał Fedorowicz, specjalista od internetu zajmujący się analizą bezpieczeństwa informacyjnego. #rosja #dezinformacja #fakenews #socialmedia #internet

Mołdawia: Jak dezinformacja zagraża demokratycznym wyborom - EURACTIV.pl

W niedzielę odbędą się wybory parlamentarne w Mołdawii. Frekwencja, szczególnie wśród mołdawskiej diaspory w krajach UE, może okazać się kluczowa dla ostatecznego wyniku i przyszłości tego strategicznie położonego kraju. Mołdawię czeka w niedzielę (28 września) jeden z najważniejszych momentów w...

Było, sam to już tu wrzucałem, ale tego gówna nigdy za wiele, zwłaszcza dziś. Wiem, że widziałaś/widzialeś. Wiem, że uważasz, że to dobre. Obejrzyj jeszcze raz. Wyślij rodzicom, niech obejrzą ponownie. Zachęć swoje nastoletnie dzieci, żeby obejrzały: na dwa, trzy razy - może byc. Udostępnij. Zrób to, god dammit. https://youtu.be/T1vW8YDDCSc?si=Sv_3WPG87JOpl1p0 #nauka #scifun #takaprawda #polska #wiadomosci #gruparatowaniapoziomu #dezinformacja #polskieonuce #wojna #nauka #byloaledobre

Zaloguj się aby komentować

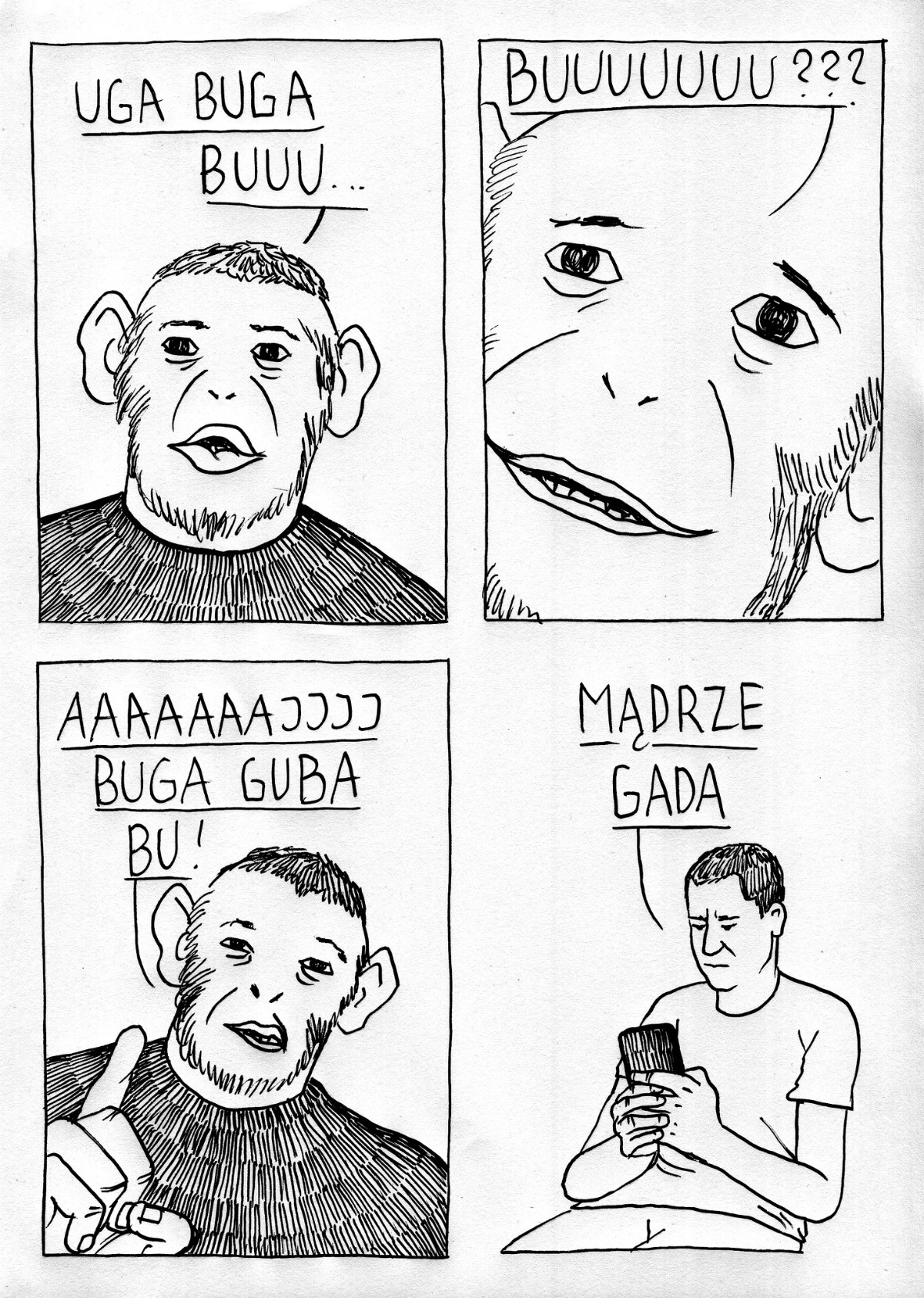

#heheszki #dzikitrener #influencer #akademiachlopskiegorozumu #dezinformacja

Zaloguj się aby komentować

Wojna

Treść dla dorosłych lub kontrowersyjna

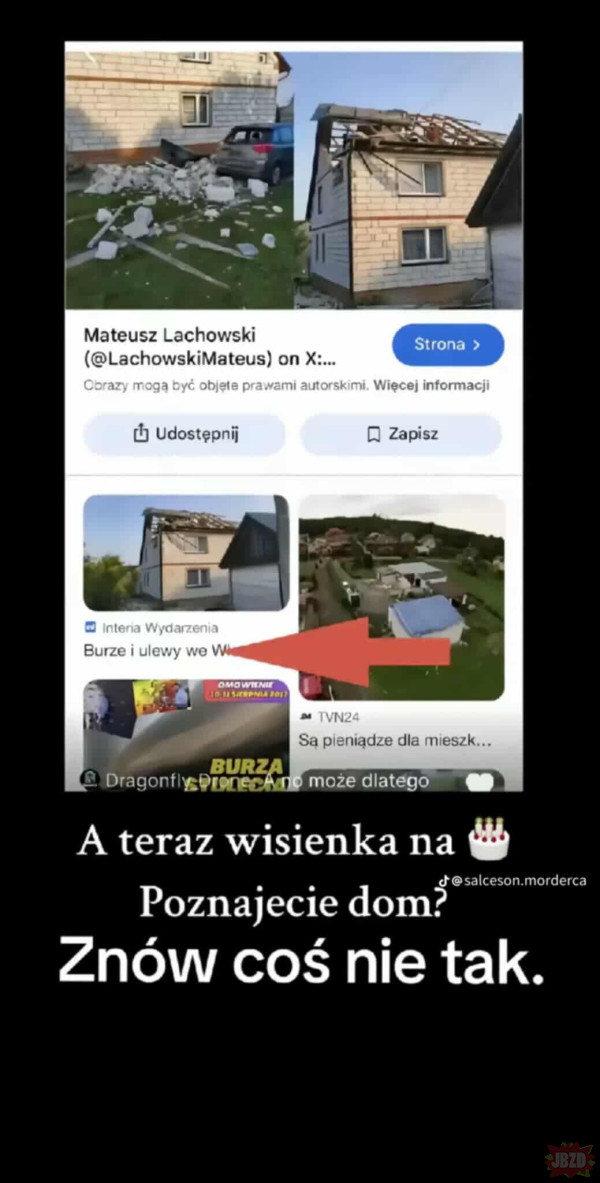

Wspaniała trollownia, to tylko pokazuje jak ludzie łykają jak pelikany bez ani odrobiny weryfikacji.

Okazuje się, że podobno ten dom zniszczyła burza.. Jakiś czas temu, a zdjęcie było już używane w artykułach.

No niestety - wyszukiwanie obrazem czy próba znalezienia tego artykułu na interii nie daje żadnych wyników.. Ludzie nie wiedzą jak łatwo taką grafikę spreparować używając samych narzędzi deweloperskich z przeglądarki..

Oczywiście, wszyscy mają tego samego skrina i nikt nie potrafi podać linka, ale spróbuj tylko zwątpić i już jesteś ich wrogiem xD

#dezinformacja #internet #szaramasa

@zuchtomek kliknij prawym, zbadaj, podmieniasz foto i gotowe. Generalnie to do korzystania z internetu ludzie powinni uzyskiwać licencję i przechodzić testy na inteligencję i wiedzę z zakresu manipulacji społecznych

Google Images całkiem często bierze podpis i obrazek z różnych sekcji strony. I wtedy masz obrazek z jednego artykułu, a tytuł z innego, bo akurat jak Google czytało stronę to artykuł z obrazkiem był w sekcji polecanych.

Zaloguj się aby komentować

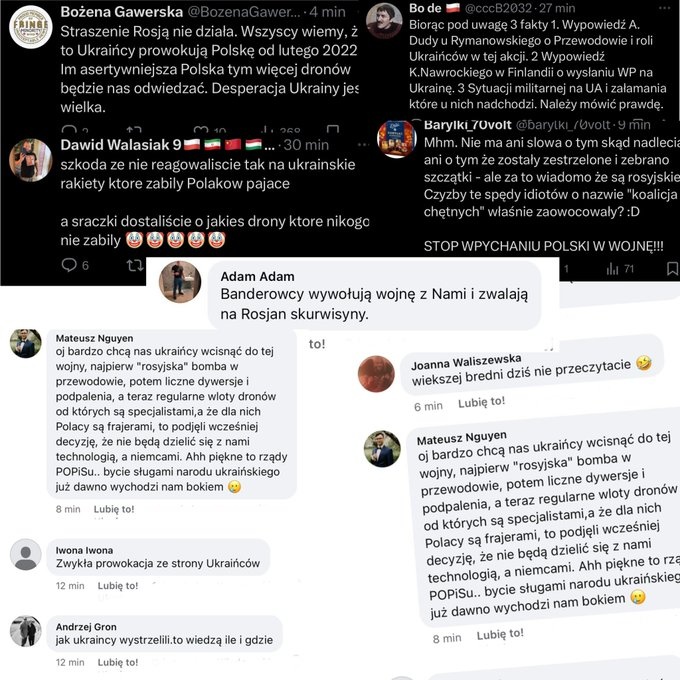

Rojskie media i tzw. blogerzy wojenni dezinformują ws. dronów nad Polską

W Rosji media prorządowe i tzw. blogerzy wojenni podają nieprawdziwe informacje dotyczące dronów, które w nocy z wtorku na środę wtargnęły w polską przestrzeń powietrzną. Prokremlowskie portale KP.ru i RIA Nowosti podważają informacje podane przez władze polskie, twierdząc, że nie podano na nie...

Od 4 rano jest zmasowany atak ruskich trolli na twitterze i fejsbuku. Goście są aktywni pod dosłownie każdym postem na ten temat i dalej pi⁎⁎⁎⁎lą, że to nie nasza wojna XD

Czemu od 4? No w m0skwie jest wtedy 6 i się zmiana zaczyna.

#wojna #dezinformacja

Zjebansko jest ostre. Naprawdę sporo można wyciągnąć z tego co się teraz dzieje w internecie. Mam nadzieję że ABW na to patrzy dość skrupulatnie

Dosłownie dzisiaj w lidlu przy kasie słyszałem jak jakaś Grażyna zagadywała do kasjerki w stylu hehe no jeszcze na nas drony jakieś wysłali, a kto to wie, może to i Ukraińcy…

Ja bym chciał żeby to wszystko były boty, ale ludzie mają wyprane mózgi, jak na tik toku wpadną w zjebaną bańkę dzikiego trenera, brauna, konfederacji itd., to już są straceni

Zaloguj się aby komentować

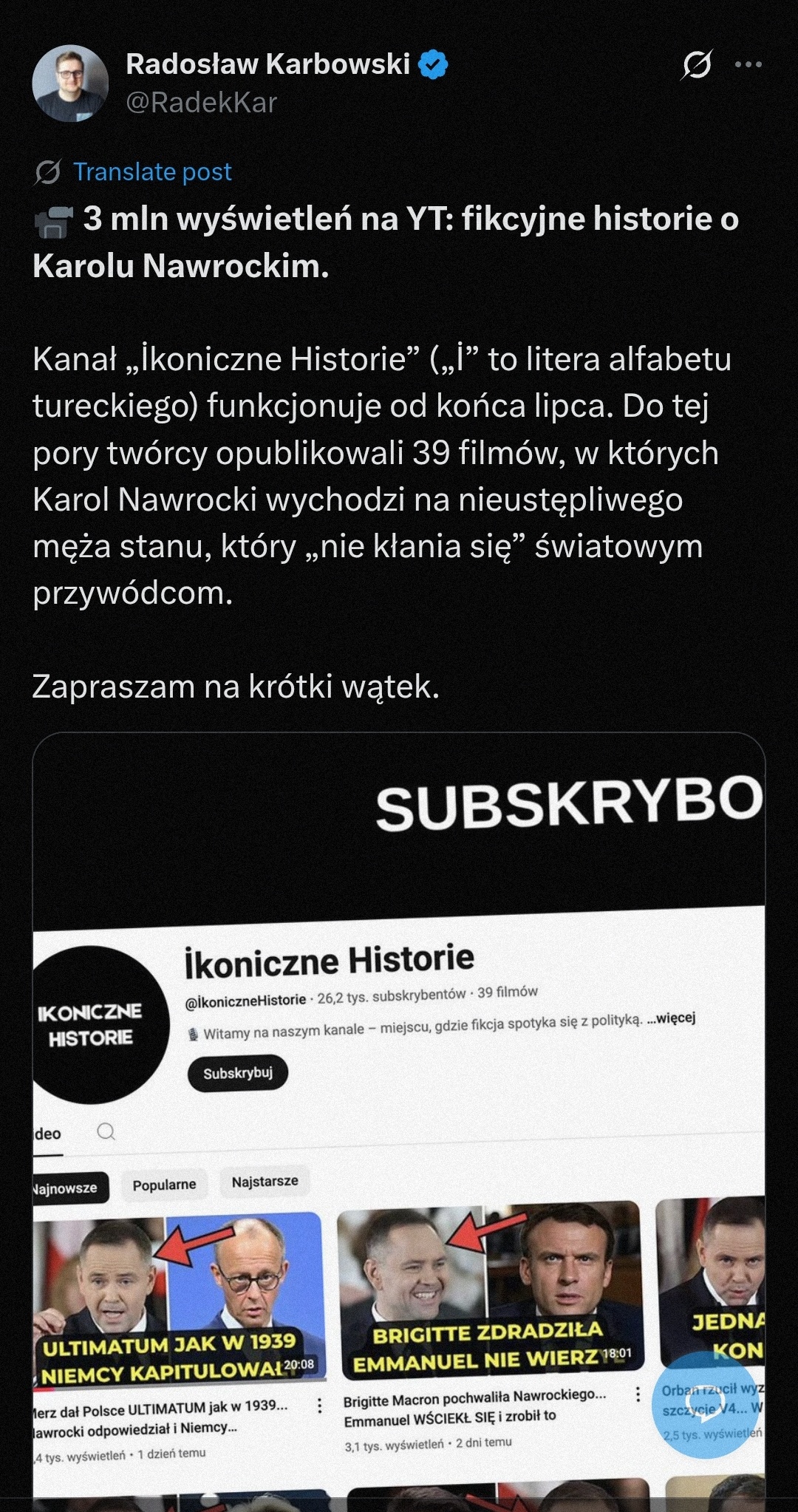

Wiecie czemu prawica wygrywa w internecie? Bo prawda ich nie dotyczy. Nie mają za grosz skrupułów, żeby kłamać ile wlezie, manipulować ile wlezie i mącić ile wlezie. No czemu nie, skoro ich wyborcy to kupują, a im samym nic za to nie grozi?

Tutaj przykład takiego kanału na jutubie, który jest wręcz wzorcowy pod tym względem. Można robić takie fejki, wystarczy na końcu opisu filmu (zajmującym maksymalną ilość znaków) dopisać, że to AI zrobiło i w sumie to nie jest prawda.

#polityka #dezinformacja

Zaloguj się aby komentować

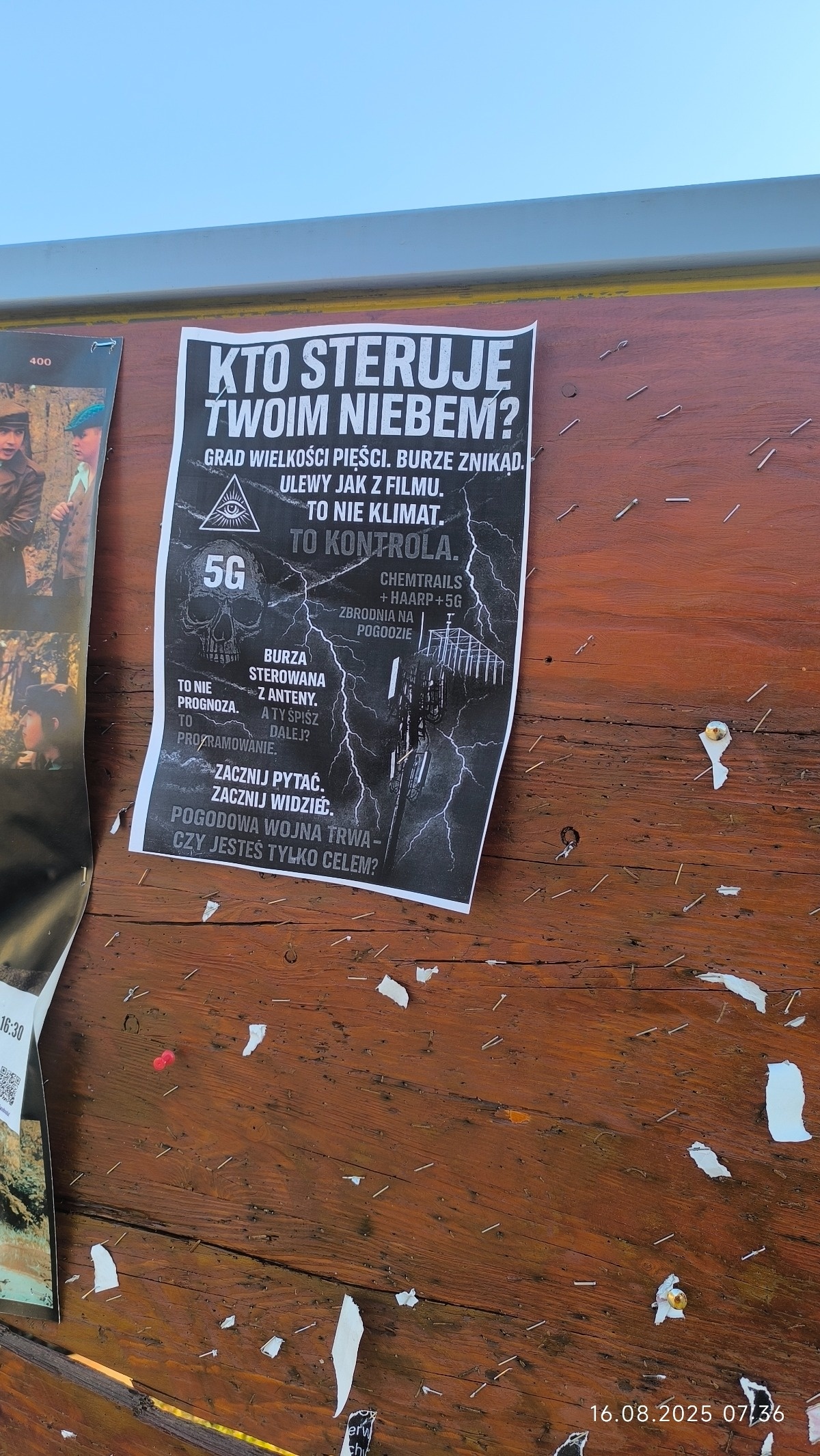

Szurek z rejonu nie odpuszcza, ja w sumie też bo wszystkie te wysrywy ładują w koszu. Plus całej historii jest taki że namierzyłem gościa co to rozpowszechnia i mnjej więcej w której porze dnia

#gownowpis #szury #dezinformacja #niewiemjakotagowac #zalesie

Na tym drugim zdjęciu chodzi o to, że Ministerstwo nie ma takich badań bo nie istnieją czy może o to, że po prostu zajmuje się tym inny organ? xD

@starebabyjebacpradem xD zdjęcie telefonu, wysokie umiejętności techniczne, dziwne że nie skan. Ja bym trollował w drugą stronę.

Zaloguj się aby komentować

Poseł PiS Dariusz Matecki zamieścił na portalu X apel do uczestników manifestacji przeciwko masowej migracji. "Mam informację z wewnątrz Komendy Głównej Policji. Pamiętacie prowokacje na Marszach Niepodległości za pierwszych rządów niemieckiego agenta? To się może teraz powtórzyć" – napisał Matecki. Polityk zaapelował, by unikać agresji i wulgarnych haseł, a osoby prowokujące fotografować i weryfikować w internecie. "Jeśli potwierdzi się, że to funkcjonariusz skierowany do prowokacji, to zrobimy mu piekło" – dodał.

Co odpowiedziała policja?

Policja stanowczo odrzuciła zarzuty posła. "Szanowny Panie Pośle, to właśnie Pana wpis jest prowokacją samą w sobie, fałszywym pomówieniem tysięcy policjantów, którzy jutro zamiast spędzić czas z rodzinami, będą pełnić służbę i robić wszystko, aby zapewnić bezpieczeństwo uczestnikom zgromadzeń oraz osobom postronnym" – napisano na oficjalnym profilu Polska Policja na portalu X. Funkcjonariusze podkreślili, że policja działa dla wszystkich obywateli, niezależnie od ich poglądów politycznych.

#polityka #dariuszmatecki #wiadomoscipolska #bekazpisu https://www.onet.pl/informacje/onetwiadomosci/policja-odpowiada-na-slowa-dariusza-mateckiego-pana-wpis-jest-prowokacja/d8tgf9v,79cfc278 #dezinformacja

Szmata już miał akcje że sam sobie niszczył swoje billboardy a potem że go ludzie nienawidzą za poglady "wielkiego samarytanina" choć jeszcze wtedy nikt go nie znał XD

Ma już pewnie doświadczenie w prowokacjach

Tyle że ja pamiętam te skurwione policyjne prowokacje.

Nie każcie mi wrzucać tych samych YT poraz enty.

Zaloguj się aby komentować

Rosyjska propaganda czy zwykła gra komputerowa? Zagraliśmy w „Squad 22: ZOV”

W najnowszej grze komputerowej rosyjskiego studia bohaterscy żołnierze walczą z ukraińskimi „gnidami”. Czy gry mogą być skutecznym narzędziem propagandy? Żeby się o tym przekonać, zagraliśmy we współtworzony przez rosyjskich weteranów „Squad 22: ZOV”.

#ciekawostki #gry #polska #rosja #propaganda...

Nie spodziewałem się banów za dezinformację i jestem pozytywnie zaskoczony. Osobiście staram się rozmawiać o czymś co jest jawną manipulacją ale czasami po prostu druga strona ignoruje każdy taki głos i tak było wczoraj w tym przypadku bo pamiętam jego wpisy.

#dezinformacja #ban

Zaloguj się aby komentować

https://journals.plos.org/ploscompbiol/article?id=10.1371%2Fjournal.pcbi.1012814

Znalazłem dosyć ciekawą pracę naukową - Mechanizmy nieufności: bayesowskie ujęcie uczenia się dezinformacji.

Dotyczy ona ogólnego wzorca podchodzenia ludzi do pozyskiwania informacji i ograniczeń umiejętności odfiltrowywania dezinformacji. To o tyle interesujące dla mnie osobiście, bo mam do czynienia z zagadnieniem wykrywania zatruwania źródeł informacji, takie hobby. A że zarówno ludzie, jak i maszyny podążają w tej kwestii podobnymi ścieżkami, szczegółowe obserwacje jednej z tych grup dają wgląd w to, jak to może wyglądać w drugiej (stąd tag #sztucznainteligencja - bo mimo wszystko, jest to powiązane). Szczególnie, że mechanizmy bayesowskie powinny się pokrywać, bo nasza rzeczywistość to łańcuchy w sensie Markowa. Wiem, brzmi to jak bełkot, ale jeśli ktoś jest ciekawy to mogę wyjaśnić. Na szybko, tutaj artykulik z perspektywy wnioskowania statystycznego: https://csc.ucdavis.edu/~cmg/papers/imc.pdf.

A wracając do artykułu, badanie w nim przedstawione pokazuje, jak mózg radzi sobie z nauką o tym, czy informacje są godne zaufania, podążając za modelem bayesowskim. Uczestnicy eksperymentu musieli rozróżnić różne rodzaje źródeł informacji – od szczerych po zmanipulowane – a ich reakcje pasowały do teoretycznych założeń modelu. Co ciekawe, wszyscy startowali z domyślnym przekonaniem, że źródła są pomocne, co jest trochę jak dawanie kredytu zaufania, zanim padnie pierwsza wątpliwość. Kiedy jednak dane były bardziej zaszumione, trudniej było zauważyć, kto próbuje manipulować. No i to jest właściwie clue samego badania - wykazanie istnienia i stopnia tej zależności.

#spoleczenstwo #dezinformacja #nauka #sztucznainteligencja

Zaloguj się aby komentować