#nvidia

Zaloguj się aby komentować

No to mamy nowe RTX 5000,

Ceny sugerowane:

RTX 5090 - Od 10 299 złotych

RTX 5080 - Od 5199 złotych

RTX 5070 Ti - od 3899 złotych

RTX 5070 - od 2849 złotych

Co w paczce?

Delikatnie zwiększona rasteryzacja,

2x większa wydajność dla RT,

Multi frame generator,

Reflex 2.0,

Nowy DLSS4.0 który z wyjątkiem multi frame generatora będzie dostępny też dla starszych RTX,

Cena kosmos,

Niemal ten sam proces technologiczny co poprzednia generacja,

Nowe złącze zasilające 12V-2x6 (do 600W na jednej wtyczce),

Topowy model 5090 o poborze mocy 575W ༼ ͡° ͜ʖ ͡° ༽

Pierwsze testy po 21 stycznia.

#komputery #ai #pcmasterrace #kartygraficzne #nvidia #gry

@Marchew po co dwa złącza zasilania, skoro jedynie pół kilowat ciągnie? I ta cena... no prawie darmowe ogrzewanie do domu

Z tymi 26fps zwiększonymi do ponad 200 to oni tak na serio? Ultra performance dlss nawet przy 4k wygląda słabo a interpolacja z 26 do 235fps moim zdaniem nie będzie mogła zwyczajnie dać poczucia większej responsywności. Co mi po płynnośći 235fps kiedy input lag pozostanie na poziomie 26fps? To będzie imo uczucie jakby człowiek był na⁎⁎⁎⁎ny a do tego płynął łodzią. No jest płynnie ale kontrola, jaka k⁎⁎wa kontrola? Sam czasem korzystam z framegen ale to nie ma zbyt wiele wspólnego z prawdziwym wysokim fps. Dysproporcja pomiędzy płynnością a responsywnością jest po prostu duża i czuć to mocno., nie ma się co czarować. NVIDIA reflex? Srefleks, k⁎⁎wa bo to było dostępne od lat i zwyczajnie polegało na zmniejszeniu ilości pre renderowanych klatek a jak ustawiało się to na 0 to efektem często był micro stutter i inne takie co właśnie miało miejsce kiedy ostatnio grałem w Horizon FW. Cuda nie istnieją i zawsze jest coś za coś i żadne bajki opowiadane przez pana w kurteczce tego nie zmienią. Tak, framegen i DLSS są fajne ale zawsze będą gorsze niż zwyczajnie wysoki fps i wysoka natywna rozdzielczość z za⁎⁎⁎⁎stym anti aliasingiem (tutaj przyznam, że dlaa robi robotę choć niestety też rozmywa obraz za bardzo w ruchu). Także nie, ficzery fajne ale brutalna moc zawsze będzie lepsza.

W sumie dobrze jest wyjaśniony temat wydajności 4090 vs 5070 w tym filmie:

https://youtu.be/KbjhsBWp_YM?t=121&si=g_CHHnp8FWoG7oBp

Tak mniej więcej od 2:00 do 3:26

Zaloguj się aby komentować

Jak tam hejterzy, hajs już nazykowany na RTX 5090? ( ͡° ͜ʖ ͡°) Myślę że bez minimum 10k się nie obejdzie.

Może w końcu da się odpalić pathtracing w 1440p z sensownym FPS bez skalowania.

#pcmasterrace #pcmr #komputery #gpu #kartygraficzne #nvidia

Zaloguj się aby komentować

Pamiętacie jak w 2020 roku wyszła seria RTX 30XX, ceny były po⁎⁎⁎⁎ne a dostępność znikoma? Kumpel zamówił 3080, zapłacił, czekał 6 czy 8 miesięcy i w końcu mu anulowali zamówienie xD #kartygraficzne #komputery #rtx #nvidia

Produkcja modeli 4080 oraz 4090 zostanie zakończona przed grudniem 2024. Obecnie modelu 4090 już praktycznie nie ma w sprzedaży. W styczniu 2025 ruszy sprzedaż serii 5080 oraz 5090.

@GucciSlav odczekałem swoje i kupiłem 3070 za 1700zł rok temu. W czasie pandemii cena dochodziła do 10k...

@GucciSlav Teraz 4060 można kupić za jakieś 1300, a 4070 za niecałe 3000. I sądze że na obu tych kartach pójdą na średnich wszystkie nowe gry.

Zaloguj się aby komentować

Robię sobie pod górkę (tj. tłok), ale co mi tam. Niech się dzieje wola nieba. Zawiadamiam wszem i wobec, że 26 października jest planowana warszawska edycja warsztatów "czarodzieje kodu":

https://www.czarodziejekodu.pl/warszawa2024/

Jest to nowa inicjatywa, która pozwala na naukę programowania najmłodszym. Grupy od 6 do 14 roku życia.

Dla tych, którzy nie wierzą deklaracjom prezesa #nvidia i chcą żeby ich dzieciaki (podobnie jak dzieciaki prezesa nvidii) liznęły coś z programowania.

W szkole córki informatyka to głównie granie w jakieś robobloki, a scratch idzie jedynie jak siedzę z młodą. Na warsztatach nie będzie już zmiłuj, ani roboloka. ( ͡° ͜ʖ ͡°)

#warszawa #programowanie #dzieci

Zaloguj się aby komentować

Po 9 latach spełniłem swoje marzenie ze studiów i kupiłem GTX Titan X xD

#pcmasterrace #nvidia #gtx #rtx #titan #komputery #gry #pcmr #gpu #kartygraficzne

Fabryczne karty nVidii są świetne od strony estetycznej. Jakbym mógł, to miałbym kolekcję ich kart tylko po to, by postawić je na regale.

Ile PLN za Titana?

@NrmvY kurde, pamiętam że 970 to już była duża karta, jak na swoje czasy. Titan tym bardziej. Ale ta 4090 to jak jakiś agregat xD bez kitu 3x więcej karty. Bawiłeś się tym, na ile taki Titan jest używalny? Wiadomo że przy 4090 wszystko będzie słabo chodzić, ale czy w ogóle gry działają bez problemu? Sterowniki już pewnie paroletnie. Fajny zakup, też pamiętam jaki to był top of the top, chociaż też nie podobało mi się trochę że 980Ti za miliony monet nie jest najmocniejszą kartą, tylko musieli coś jeszcze droższego wymyśleć. Z drugiej strony, to też było celowane oficjalnie bardziej pod użytkowników Quadro. A że kupowali to raczej entuzjaści gier, to inna sprawa xD

Zaloguj się aby komentować

#pcmasterrace #pc #gry #komputery #grykomputerowe #xbox #playstation #ps5 #nvidia #amd #steamdeck

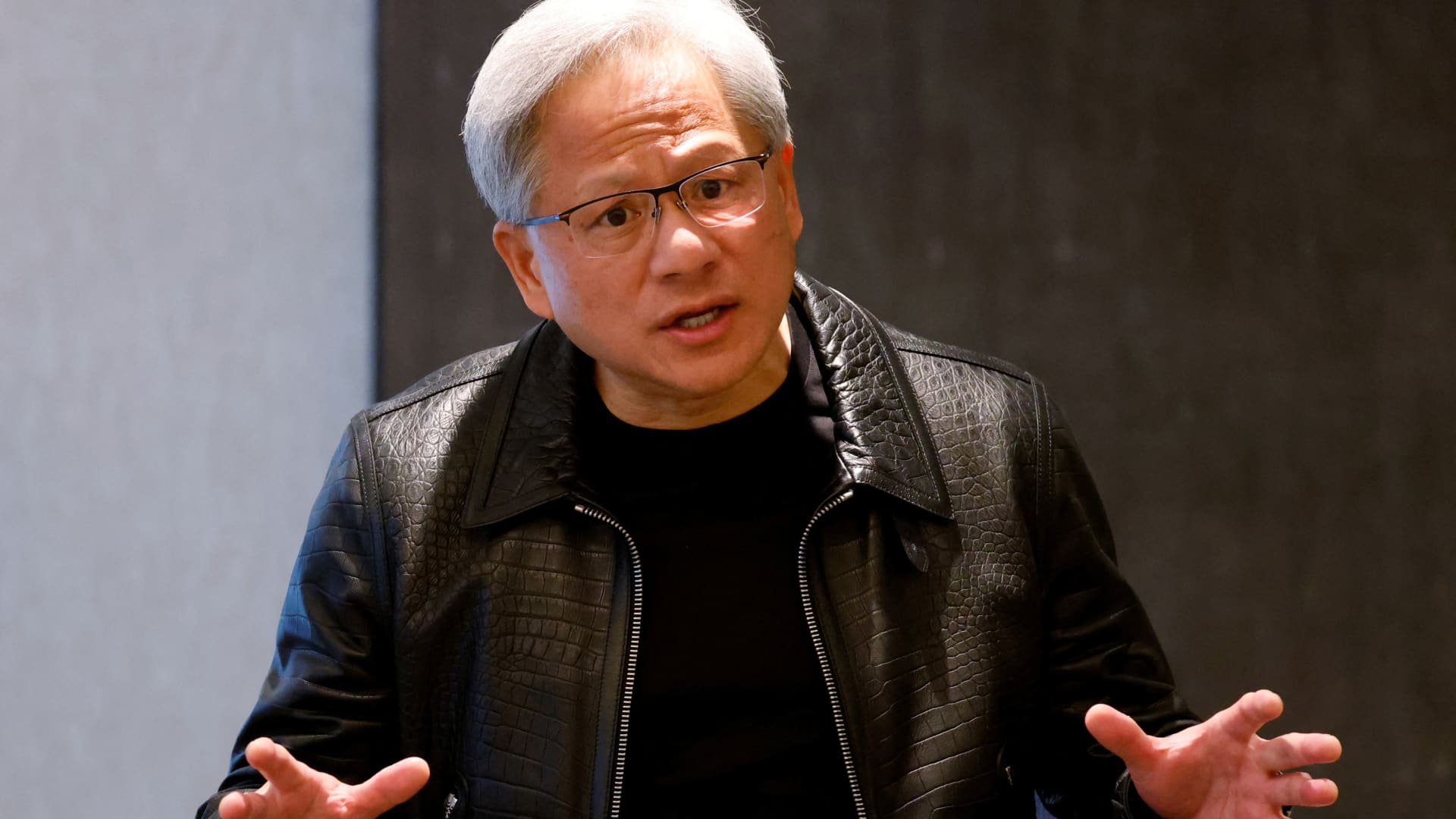

Kurteczka powiedział "frame generation działa tylko na serii rtx4xxx bo ta technologia wymaga dedykowanych rdzeni w gpu". Inaczej się, k⁎⁎wa, nie da. I teraz przychodzi takie AMD, które tego nie wiedziało i robi to dla większości kart graficznych. Początki co prawda były trudne bo w Forspoken i Aveum działało to mocno średnio ale odpalam niedawno na mojej upośledzonej RTX 3060 12gb Ghost Of Tsushima w której mamy już Fsr 3.1 i z miejsca pojawia mi się banan na twarzy. Framegen? Działa. VRR? Działa a synchronizacja fps z odświeżaniem monitora idealna. Artefakty? Nie więcej niż na DLSS framegen które to jakiś czas temu testowałem, czyli rzecz w ruchu niemal niedostrzegalna. Input lag? Jestem na niego jeszcze bardziej wyczulony niż na artefakty i grając na padzie nie widzę znaczącej różnicy w porównaniu do framegen na off. Wczoraj Horizon dostało łatkę i tam działa to jeszcze lepiej. Nie da się, panie Jensen, nie da się więc zaraz lecę po kastrata RTX 4060 z 8gb vram które to już od dłuższego czasu nie wystarcza do 1080p w 3/4 nowych gier a moją 3060 wypierdalam do kosza. Konkurencja - coś, czego wielu fanboyów nie lubi i jednocześnie najkorzystniejsza sytuacja dla nich samych.

@Jim_Morrison skórzany chłop powiedział, że się nie da, uwierzył mu nikt, ale to nieważne bo w świat poszedł komunikat "Chcesz DLSS w nowych grach? Kup RTX4xxx bo staroci nie wspieramy"

I poszli ludzie i kupili (ja w sumie też xD).

@Jim_Morrison to wszystko jest tym bardziej komiczne biorąc pod uwagę fakt, że w takim cyberpunku ghosting przy DLSS jest tragiczny, a w wiedźminie 3 przy DX12 to w ogóle gra mi się wysypuje i muszę grać na DX11 pomimo, że powinienem się cieszyć z RT (który jest prawie niezauważalny xD)

dziękuję pan kurteczka.

marketing NoVideo to jest majstersztyk, a przy pomocy paru aktywnych trolli i oddanych fanów to już można niemal wszystko

O ile zakup nvidii od 4070 w górę moge zrozumieć tak śmieszą mnie ludzie którzy kupują 4060 z 8gb vram mówiąc o tym że ma dlss i Ray tracing.

Gry z Ray Tracingiem wymagają mocniejszej karty, raczej od 4070.

DLSS - przy 8gb vram to chyba jedynie do upscalingu z 720p do grania w gry 1080p bo 8gb to za malo dla części obecnych gier nie mówiąc już o przyszlych.

Tak czy siak ja kupuję od AMD bo pokazali że:

- można wydawać kilka generacji procesorów na tą samą podstawkę

- można wydać FSR, frame generator dostępny na wszystkich kartach w tym konkurencji.

- w podobnej cenie można dać więcej vramu od konkurencji, a ten vram to bardzo ważna rzecz, gdy brakuje mocy to można wyłączać różne opcje bez zjeżdżania z jakością tekstur, a gdy brakuje vram to trzeba obniżać jakość tekstur.

Generalnie takie zachowania należy wspierać i głosować portfelem, im większy ktoś ma monopol tym bardziej może olewać kupujących.

Zaloguj się aby komentować

Pracownicy, którzy dołączyli do Nvidia 5 lat temu, są teraz milionerami i prowadzą życie na "półemeryturze"

Nvidia (NASDAQ: NVDA) odnotowała niesamowity wzrost w ostatnich latach. Od początku 2024 roku akcje firmy wzrosły o 167%. W ciągu ostatnich pięciu lat wzrosły o imponujące 3,450%.

https://finance.yahoo.com/news/employees-joined-nvidia-5-years-160012281.html

W sumie ciekawy problem.

Źródło: https://www.tiktok.com/@trading101/video/7384254329965792555

#programowanie #programista15k #nvidia

W sumie ciekawe ilu jest takich pracowników co mają te ponad 10 000 000 $ w akcjach. Załóżmy że jakieś 10% wszystkich tam pracujących. Jak sprzedaż takiej ilości akcji wpłynie na cenę Nvidii na giełdzie oraz co się stanie jęzeli te osoby powiedzą: pi⁎⁎⁎⁎le nie robię na tego prywaciarza złodzieja i pójdzie leżeć na trawkę pindolem do góry.

Zaloguj się aby komentować

Siostrzeniec jeszcze nie zbudował kompa do grania. Ale chciał jeszcze raz żebym mu podał podzespoły.

Droższy wariant za 7586,34 zł.

Tańszy wariant za 6097,32 zł (gorsza karta graficzna i procesor).

Wariant droższy:

3599 Grafika NVIDIA GeForce RTX 4070 Ti SUPER

1484,01 Procesor AMD Ryzen 7 7800X3D 8 x 4,2 GHz gen. 4

125 Chłodzenie procesora ENDORFY Fera 5

439 Patriot Viper Venom DDR5 32GB 2X16GB 6000MHz

519,34 Zasilacz Corsair RM750x SHIFT 2021

199 Obudowa Bandit Power BPG3 Midi Tower

527,99 Dysk SSD Patriot Viper VP4300 Lite 2TB M.2 PCIe

679 Płyta główna Gigabyte B650 Eagle Ax

Wariant tańszy:

2699 Grafika Palit GeForce RTX 4070 Super ! Dual 12GB GDDR6X

908,99 AMD Ryzen 5 7600X 4.7GHz 6-core BOX

Monitor ma o rozdzielczości 2k (używa na ten moment do konsoli).

PYTANIE: Co zmienić w obu wariantach?

Do wersji z AM4 DDR4, nie mogłem dobrać płyty głównej, która by miała dwa sloty M.2 PCIe NVMe 4.0 x4, więc porzuciłem taką opcję.

#sprzetkomputerowy #pcmasterrace #pc #nvidia #geforce #dysk #ssd #skladamkomputer

@fewtoast imo ten drożdży wariant jest ogólnie spoko. Fakt faktem, że do tej karty kupiłem jednak zasilacz 850W. O płycie się nie wypowiem, za to nie daj sobie wcisnąć prockow Intela - AMD obecnie króluje w tej kwestii i mówię to jako były fanboy Intela.

Widzę, że cena 4070 powoli robi się znośna. Różnica między 'Super', a 'TI Super' gigantyczna - śmiem wątpić czy warto.

Powoli zbliża się czas emerytury dla mego RTXa2080, ale to jeszcze nie jest ten moment...

@Bielecki - a to potrzebuje aż tak mocnego zasilacza, bo mnie się wydaje, że porządne 600/650W to już git?

Zaloguj się aby komentować

Trzeba się przygotować na premierę RTX 5000 ( ͡° ͜ʖ ͡°)

#komputery #pcmasterrace #zasilacze #grykomputerowe #hobby #corsair #nvidia

Zaloguj się aby komentować

Siostrzeniec buduje kompa do grania, budżet **8-9 tysięcy złotych**.

To co wybrał razem jest 7129,77 zł (nie szkodzi, taniej może być).

link Karta graficzna GIGABYTE GeForce RTX 4060 Ti Gaming OC 16GB DLSS 3 2299 zł

link Procesor AMD Ryzen 5 8600G 1028,50 zł

link Płyta główna GIGABYTE X670 Aorus Elite AX 999 zł

link Pamięć RAM KINGSTON Fury Beast RGB 64GB 5200MHz 969 zł

link Dysk CRUCIAL T700 2TB SSD 1226,27 zł

link Zasilacz MSI MPG A850GF 850W 80 Plus Gold 509 zł

[link](link) Obudowa KRUX Trek KRX0015 99 zł

Monitor ma o rozdzielczości 2k (używa na ten moment do konsoli).

Podstawy mu podpowiedziałem, dobranie proca AM5, dobranie płyty głównej do proca, RAM do proca, chciał 96 GB RAM ale powiedziałem żeby wziął 64 GB, dysku SSD z PCIe 5.0 bo najwydajniejszy, mniej wydajny zasilacz bo po co taki (ale i tak jest za mocny, jak rozumiem 650 W by wystarczył).

I pytania:

1. Proc inny? AMD Ryzen 5 7600X? AMD Ryzen 5 7600(polecony gdzieś do tej karty graficznej, ale niedostępny teraz na mediaexpert)?

2. Zasilacz inny? Może być ten: link Zasilacz ENDORFY Supremo FM5 650W 80 Plus Gold 369 zł?

3. Osobne chłodzenie do proca? Ja mam SILENTIUMPC Fortis 5 ale niedostępny w mediaexpert.

4. Ta obudowa to pomieści?

5. No bo karty graficznej lepszej raczej nie ma? Wiadomo, takiej którą się da wykorzystać i nie jest z kosmosu cena.

#sprzetkomputerowy #pcmasterrace #pc #nvidia #geforce #dysk #ssd #skladamkomputer

@fewtoast Ta konfiguracja pod wieloma względami jest bez sensu (chyba, że samo wydawanie pieniędzy dla wydawania pieniędzy) i już lepiej się kierować którąś np. od liptona:

https://techlipton.pl/2024/polecane-zestawy-komputerowe-marzec-2024/

@fewtoast Jest naprawdę słabo za te pieniądze.

Grafa 7800 XT to absolutny TOP jeśli chodzi o cena/wydajność.

Procek strzelaj w ryzen 7600 albo intel 14600KF. Na tym intelu ciskasz DDR4. DDR5 to zjadacz pieniędzy.

64GB ram to gier to totalny absurd. Jedynie kilka pozycji w rozdzielczości 4k zapcha 16 GB RAM, serio! Wkładasz 32GB RAM i jest super z zapasem! Ino zostaw 2 wolne sloty na kolejne 32GB gdzieś za 5 lat lub później.

Zasilacz 850W dla w/w configu to totalny absurd! Tam i 500W w zupełności wystarczy.

Dla mojej propozycji wsadź jakiegoś be quiet serii 11 o mocy 750 i będzie dobrze.

Obudowa za taką cenę to chyba zamiast blachy ma papier. Btw zasilacz w tej obudowie jest mocowany u góry co jest według mnie nieporozumieniem i kompletnym przeżytkiem. Dodatkowo pewnie obieg powietrza również jest nieprzemyślany co może powodować większy hałas i wyższe temperatury, no ale czego oczekiwać po taniej budżetówce.

Weź zrób tak jak ci pisze kolega i złóż siostrzeńcowi kompa na podstawie części polecanych w zestawach przez techliptona.

Zaloguj się aby komentować

Nvidia reveals Blackwell B200 GPU, the "world’s most powerful chip" for AI

Ta szafa robi chyba największe wrażenie:

DGX Superpod for DGX GB200, which combines eight systems in one for a total of 288 CPUs, 576 GPUs, 240TB of memory, and 11.5 exaflops of FP4 computing.

#technologia #nvidia #artificialintelligence #sztucznainteligencja

Zaloguj się aby komentować

Naszym zadaniem jest tworzenie technologii obliczeniowych, tak aby nikt nie musiał już programować, a językiem programowania był człowiek: każdy na świecie jest teraz programistą – to jest cud.

- Jensen Huang, CEO firmy NVIDIA

Źródło: https://blogs.nvidia.com/blog/world-governments-summit/

#wiadomosciswiat #programowanie #programista15k #artificialintelligence #sztucznainteligencja #nvidia

Zaloguj się aby komentować

Czy to normalne, że monitor zmienia ustawienie (częstotliwość odświeżania) w dokładnie 6 sekund?

Czy to nie powinno trwać krócej?

Monitor Gigabyte M32QC połączony DisplayPort

Grafika GeForce RTX 3060 Ti

Płyta główna ASRock A620MHDV/M.2+

Arch Linux z Cinnamon

#monitor #sprzetkomputerowy #pcmasterrace #pc #nvidia #geforce #linux #archlinux #cinnamon

Zaloguj się aby komentować

Nvidia passes Alphabet in market cap and is now the third most valuable U.S. company

Nvidia surpassed Google parent Alphabet in market capitalization on Wednesday. It’s the latest example of how the artificial intelligence boom has sent the chipmaker’s stock soaring.

#technologia #nvidia #gielda

Zaloguj się aby komentować

Dziwny bug, związany z HDMI/DisplayPort i częstotliwością odświeżania i przełączaniem między TTY.

Tak to wygląda:

HDMI 60 Hz i przełączam z TTY1(z Cinnamon), na TTY2 - trwa 7 sekund.

HDMI 60 Hz powrót z TTY2 na TTY1 - **trwa 1 sekundę**.

DisplayPort 60 Hz i przełączam z TTY1(z Cinnamon), na TTY2 - trwa 6 sekund.

DisplayPort 60 Hz powrót z TTY2 na TTY1 - **trwa 6 sekund**!.

Na HDMI powrót trwa tylko sekundę. I tak powinno być zawsze, nie?

A jednak każdy inny przypadek trwa 6-7 sekund. To absurdalnie długo, i chyba nie ma żadnego powodu, żeby tyle to trwało?

Z kolei przy wyższych częstotliwościach odświeżania, już nawet HDMI powrót trwa 6-7 sekund.

To też jest zaskakujące zachowanie. Jakby system/sterowniki(?) obsługiwały tylko dokładnie HDMI 60 Hz, ale też nie do końca, bo przełączenie na TTY2 nadal trwa za długo.

Co mogę z tym zrobić? Czy tylko można liczyć na aktualizacje sterowników, żeby coś się poprawiło?

GeForce RTX 3060 Ti 8 GB

ASRock A620MHDV/M.2+

AMD RYZEN 5 7500F AM5

Kingston Fury Beast Black 16GB DDR5 (KF556C40BB-16)

#nvidia #linux #archlinux

@fewtoast A nie napisałeś najważniejszego, X-Org czy Wayland? Zobacz czy jest różnica na jednym i na drugim. Sprawdziłbym też czy podobnie to wygląda na innym monitorze.

Btw serio aż tak często przełączasz się na TTY, że zwracasz uwagę na to ile się przełącza? Po co wgl się tam przełączać, ja to jedynie korzystam z TTY jak mi się desktop zatnie i trzeba zresetować Plazmę albo całego X-Orga. Zresztą samo przełączenie i powrót potrafi czasem odciąć pulpit jak się zaciął.

Z ciekawości sprawdziłem teraz to u mnie na X-Orgu przełączanie po HDMI w obie strony trwa po ok 3 sec.

Co mogę z tym zrobić? Czy tylko można liczyć na aktualizacje sterowników, żeby coś się poprawiło?

Jako, że masz kartę Nvidii to na poprawę i aktualizacje błędów w ich sterownikach na Linuxie to nie masz co liczyć xDDDDD

Właśnie byłem przelogować się na sesje z Waylandem żeby zobaczyć z ciekawości czy jest jakaś różnica i u mnie nie ma w sumie, też ok 3 sec.

Ale żeby było śmieszniej to jak chciałem wrócić na X-Orga to po zalogowaniu wyszedł komunikat, że nie można było wystartować plasma-desktop i Xorg się wywalił XDDDD. Musiałem go zrestartować z TTY eh xd

Zaloguj się aby komentować

Śledzi z was ktoś ostatnio FSR3?

Takie tldr to: AMD udostępniło otwarty kod FSR3 i moderzy już działają.

AMD udostępniło otwarty kod technologii FidelityFX Super Resolution 3 (FSR 3) dla DirectX 12 i Unreal Engine 5, co umożliwia programistom integrację tej technologii w swoich grach. FSR 3 zastępuje poprzednią wersję, FSR 2, oferując nie tylko czasowe skalowanie, ale także generację klatek. W odróżnieniu od konkurencyjnej technologii DLSS Frame Generation firmy Nvidia, FSR 3 jest otwartym źródłem, co daje większą swobodę programistom i obsługuje szerszy zakres kart graficznych.

Dawniej do tematu podchodziłem z takim "meh" ale ostatnie testy pokazują, że stare karty naprawdę mogą dostać drugie życie bez widocznej dla przeciętnego kowalskiego różnicy jakości. Taki cyberpunk kilka dni temu miał np. widoczne problemy z HUDem + tylne cienie samochodów (artefakty). Zostało to poprawione i aktualnie nie widać jakichś niedociągnięć (Luke FZ mod).

2x klatki przy tym samym poborze mocy (konsole i konsole przenośne lubią to) to jak dla mnie super sprawa

Z jeszcze innej strony kiedy technologia będzie już dopracowana to będzie można się zastanowić nad przejściem na wyższą rozdziałkę bez wymiany podzespołów

#pcmasterrace #amd #nvidia #rozkminy

@nobodys to jest oszustwo, lepiej zjechać trochę z ustawieniami graficznymi, efekt będzie lepszy.

nawet ten zachwalany DLSS 3 to dziadostwo, same artefekty, ghosting i inne problemy.

@Erebus oczywiście, że tak - w końcu to nie są faktycznie wygenerowane klatki. Ale jak ktoś np ma gówniany sprzęt i gra np w 15-20 fps, to raczej bez problemu się zdecyduje na 30-40 fps kosztem trochę gorszej jakości obrazu/artefaktów. Zjechanie z detalami mu takiego skoku wydajności nie da.

@Erebus We wcześniejszej wersji FSR a nawet nowej wersji przed udostępnieniem otwartego kodu też tak myślałem.

W każdym razie jestem pozytywnie nastawiony, bo jakiekolwiek artefakty mogą być w przyszłości rozwiązane, co daje wiele nowych możliwości.

Zaloguj się aby komentować

Od zawsze byłem fanboyem kart NVIDIA. Na początku roku dałem szansę AMD i.. żałuję, że dopiero teraz

Benchmarki benchmarkami, ale coś co mnie w ostatnich latach irytowało w kartach NVIDIA to software..

GeForce Experience dostaje u mnie minusa już przez to, że trzeba zakładać konto i nadal regularnie program wylogowywał. Jego wygląd i nakładki okazały się nieintuicyjne.

Dodatkowo NVIDIA czasami potrafiła sama zmieniać ustawienia, szczególnie kiedy wymuszała aktualizację do nowszej wersji (np. wyłączała się opcja nagrywania powtórki).

Jak jest w przypadku AMD? Instalujesz software, ustawiasz i pora na CSa. Wygląd samego AMD Software Adrenaline Edition gdzie wszystko jest w jednym miejscu dużo bardziej mi odpowiada i nie czuję się taki zagubiony jak w przypadku Geforce Experience.

W przeszłości nie zwracałem na to uwagi, bo byłem przekonany, że tylko NVIDIA umie w karty graficzne. W przyszłości na pewno będę dużo bardziej zwracał uwagę na to, na jakim etapie jest soft jednej i drugiej firmy, bo same FPSy w moim przypadku to nie wszystko.

#pcmasterrace #amd #nvidia #gownowpis #zalesie

@nobodys ogólnie spoko, że ci pasuje bardziej software AMD i jesteś zadowolony, ale wychodzi na to, że masz bardzo specyficzne kryteria jeśli chodzi o wybór karty graficznej. Bardzo, bardzo.

@rakokuc Owszem, bo mi w zupełności wystarcza dawny standard czyli 60 stabilnych klatek w FHD na najwyższych albo w miarę wysokich detalach. Priorytety to stabilność + kultura pracy + soft + rozsądny pobór mocy (przy V-Syncu to nie problem).

Wiem, że na rynku jest teraz gonitwa za rozdzielczością i nowymi standardami klatek, ale mi to do szczęścia (jeszcze) nie potrzebne

@nobodys niedawno się także przesiadłem na AMD. Mam ich procka to i kartę graficzną wsadziłem do PC. Caly czas byłem na NV. Z tym co teraz oferuje NV i za ile $ - niech spadają na drzewo.

Tak, software do Radeona daje radę - jestem bardzo mile zaskoczony.

@nobodys Pierwszy krok do bycia Linuksiarzem ( ͡° ͜ʖ ͡°) https://youtu.be/OF_5EKNX0Eg?si=odWhiiQWQUZpJwwy

Zaloguj się aby komentować

Omg w końcu #nvidia dodała wsparcie dla "GAMMA_LUT" w Waylandzie w swoich sterownikach dla #linux . Co to oznacza? Że w końcu na KDE Plazmie (i innych DE/WM) będzie działać Night Color czyli filtr niebieskiego światła. To była ostatnia rzecz która trzymała mnie przed przejściem na Waylanda i porzuceniem X-orga. Widziałem 3 dni temu artykuł o tym (link) ale dopiero godzinę temu wszedł update "nvidia-dkms" w repo Archa. Zainstalowałem i mogę potwierdzić, że działa. Ludzie o to prosili od jakiś przynajmniej 2-3 lat no ale lepiej późno niż wcale.

Zaloguj się aby komentować