Geologiczne morderstwo

#heheszki #okazjonalneXKCD

Otwieram nowy tag, bo lubię te komiksy. Tak, jestem dziwny. Nie, dobrze mi z tym

Geologiczne morderstwo

#heheszki #okazjonalneXKCD

Otwieram nowy tag, bo lubię te komiksy. Tak, jestem dziwny. Nie, dobrze mi z tym

Zaloguj się aby komentować

Teraz to, co tygrysy lubią najbardziej, teoria strun i Wielki Zderzacz Hadronów.

Artykuł popularny (dam w komentarzu jego automatyczne streszczenie po polsku, jak tylko je sprawdzę) - https://thedebrief.org/could-the-large-hadron-collider-disprove-string-theory-scientists-say-yes-with-the-right-discovery/

Oryginalna praca - https://journals.aps.org/prresearch/pdf/10.1103/PhysRevResearch.7.023184

Zagadnieniem postawionym przez te artykuły jest, czy można obalić teorię strun (a właściwie każdą teorię z tej działki) jakąś obserwacją, którą można wykonać w zderzaczu. Odpowiedź brzmi - można. Dziękuję, to wszystko

A na poważnie, można bo zaproponowana metoda daje dosyć wygodne narzędzie falsyfikacyjne. Teorie strun (bo jest ich kilka) wykluczają pewne klasy cząstek ze względu na strukturę samych teorii i mechanizmy tworzenia cząstek. W tych teoriach, cząstki są wibracjami wielowymiarowych strun wokół wymiarów zwiniętych. Niezależnie od konkretnej teorii, nie dopuszczają one np. pentapletu z neutralnym fermionem Majorany. Model standardowy też go nie zawiera, ale są konkretne propozycje i opisy - https://journals.aps.org/prd/abstract/10.1103/PhysRevD.96.095017 lub https://arxiv.org/pdf/1106.1069 .

Wielki zderzacz hadronów ma wystarczającą moc, by wyprodukować pentaplety i nonoplety (400GeV-kilka Tev), więc ta droga falsyfikacji jest jak najbardziej sensowna. Wykrycie takich pentapletów położy wszystkie teorie strun.

#fizyka #technologia #lhc #ciekawostki

@ataxbras Kurde, przypomniałeś mi jak ja k⁎⁎wa głupi byłem i czytałem na stronę LHC propozycje pracy dla programistów C# i k⁎⁎wa w głowie sobie powiedziałem, że "no nie ja jestem miekiszon nie dam rady, kim ja jestem ehh". To była dla mnie pracą marzeń.

Jeszcze fajne są hipotezy o "dziwadełku".

Jeśli przy okazji położy model standardowy, to chyba są na to marne szanse? Ten, w przeciwieństwie do teorii strun, dał wiele sprawdzonych później predykcji

Teoria strun kojarzy mi się nomen omen właśnie ze strunami. Czyli jak daleko można naciągnąć struny matematyki, żeby na siłę wyprodukować coś, co przy horrendalnych założeniach może się jakoś tam spinać.

Gdzieś czytałem opinię która do mnie trafia, że do tej pory największe przełomy i odkrycia na gruncie fundamentalnym, były w swej istocie proste, bo najpewniej taka może być ostatecznie rzeczywistość. Prosta w konstrukcji, skomplikowana w możliwościach. A teoria strun jest jakby tego zaprzeczeniem i stawaniem na głowie, żeby naciągnąć każdą strunę, aby tylko na końcu jakimś cudem się to zgrało.

Niemniej to opinia na podstawie tego co czytam, czyli źródeł popularnonaukowych i opinii osób które się znają (jak chociażby ty)

Zaloguj się aby komentować

Artykuł popularny - https://kopalniawiedzy.pl/prawo-Kirchhoffa-promieniowanie-absorpcja-emisja,37960

Artykuł źródłowy - https://arxiv.org/pdf/2501.12947

Tym razem będzie o cieple. Ciepełko lubimy (do pewnego stopnia). Ale z ciepełkiem jest problem taki, że prawo promieniowania cieplnego Kirchhoffa (bo gość bawił się nie tylko układami elektrycznymi) - https://pl.wikipedia.org/wiki/Prawo_Kirchhoffa_(promieniowanie) - wyklucza swobodne sterowanie jego przepływem.

Może się wydawać, że to mały problem, jednak nasza cywilizacja zależy od maszyn cieplnych dużo bardziej, niż się większości ludzi wydaje. Od turbin parowych w elektrowniach po silnik Passata Twojego starego. Ale to nie wszystko, a właściwie to dopiero początek. Ciepło jest koszmarnym ograniczeniem w elektronice i elektryce (@myoniwy może Wam coś o tym opowiedzieć). Główną przeszkodą w tworzeniu układów scalonych z jeszcze większą ilością tranzystorów w jeszcze większej ilości warstw nie jest tylko rozdzielczość litografii (która jest już i tak blisko limitu kwantowego - muszę o tym kiedyś przy okazji napisać), ale przede wszystkim odprowadzanie ciepła.

I ta praca, którą tu przywołuję jest przełomowa (choć pewnie zniknie w szumie informacyjnym), dużo bardziej niż następny nowy pomysł na baterię. Może niekoniecznie ta praca, może inne metamateriały będą jeszcze lepsze, ale drastyczne złamanie symetrii prawa Kirchoffa jest rzeczywiście doniosłym osiągnięciem, bo pozwoli na arbitralne i skuteczne sterowanie przepływem ciepła. Przełoży się to na elektronikę wysokiej skali integracji, na wydajniejsze ogniwa fotowoltaiczne i wiele innych dziedzin.

#fizyka #ciekawostki #nauka #technologia

Jeśli macie pytania, to zadawajcie je.

Zaloguj się aby komentować

Głodzenie robaków i co z tego wynika...

Kolejny artykuł, który wpadł mi w feedzie ScienceDirect . Wydaje się być interesującą obserwacją, więc się tym podzielę.

Naukowcy, kiedy w okolicy brakuje jednostki podobnej to 731 głodzą robaki. Dlaczego robaki? Prawidłową odpowiedzią, wbrew pozorom, nie jest że są tańsze i komisje etyczne się nie przyczepią, jak w przypadku myszy, rezusów, czy ludzi. A w każdym razie nie jedyną prawidłową odpowiedzią. W tym przypadku chodzi o prostotę modelu biologicznego, jego przymitywizm, zarówno w budowie, jak i w zaawansowaniu ewolucyjnym.

Głodzono je po to, by obserwować zmiany metaboliczne. Okazuje się, że robaki pozbawione genu TFEB, po głodzeniu, a później dostarczeniu pożywienia, przełączały się w stan przyspieszonego starzenia się. To znaczy, znacząco zwiększał się poziom uszkodzeń komórek. Robaki nie mogły wyjść ze stanu uśpienia, anabiozy, w jaki wprowadzają się w przypadku braku pożywienia, a jednocześnie zestaw stresów związanych z podażą żywności (oksydacyjne, nitracyjne i inne) uszkadzał ich organizmy. Pojawiła się też deregulacja działania komórek macierzystych.

Wskazuje to, że ten gen (lub upośledzenie jego ekspresji) może być odpowiedzialny za proces starzenia się u organizmów wyższych, przynajmniej w części. Jednocześnie, praca sugeruje związek mechanizmu uśpienia obserwowanego u robaków z tym obserwowanym w komórkach nowotworów, co może otworzyć nowe kierunki badań nad niszczeniem tychże.

Oryginalny artykuł: https://www.nature.com/articles/s43587-025-00911-4

#nauka #biologia #biotechnologia #nowotwory #ciekawostki

Zaloguj się aby komentować

Kleszcze...

Kochamy te małe stworzonka, a jeszcze bardziej te mniejsze, które sobie w nich żyją, słodkie bakteryjki Borrelia burgdorferi. To one robią sobie impry w organizmach ludzi, czasem z niemiłymi konsekwencjami.

Może jednak istnieć mechanizm powstrzymania tych słodziaków. A właściwie, spowodowania, by nie mogły się łatwo przenosić za pośrednictwem kleszczy. Bo w kleszczach największym problemem nie jest ich miłość do naszej krwi, ale pasażerowie na gapę, których nam zostawiają, w szczególności bakterie Borrelia burgdorferi. Praca, którą podrzuciło mi ScienceDirect, dotyczy właśnie mechanizmu w jaki te bakterie zapewniają sobie przeżycie (i wektor infekcji) wykorzystując te biedne kleszcze. Co więcej, okazuje się, że ten mechanizm można sabotować. Bakterie wykorzystują aktywację receptora ATF6 odpowiedzialnego za regulację cholesterolu (którym te bakterie się żywią) za pomocą stomatyny.

I tutaj w końcu jestem w okolicach mojej działki (kiedyś się tym zajmowałem od strony obliczeniowej i modelowania). Podaż stomatyny i aktywację ATF6 można blokować, uniemożliwiając tym samym rozwój populacji bakteryjnych. Jeśli zrobi się to dobrze, bez znaczącej zmiany dla podaży w przypadku braku tych populacji, to jest to dosyć sprytny sposób na stłumienie tego wektora zakażeń przez borellię et consortes. Dzieje się tak dlatego, że nadpodaż cholesterolu to wydatek energetyczny dla nosiciela (kleszcza). Jest on zatem ewolucyjnie upośledzony, bo nie wydaje się, by był to stosunek symbiotyczny - bakterie są tutaj pasożytami. Zatem, wprowadzenie populacji zmodyfikowanych genetycznie kleszczy, które blokowałyby próby bakterii w kierunku wykorzystania cholesterolu, może doprowadzić do zastąpienia populacji kleszczy podatnych w jakimś horyzoncie czasowym (przy odpowiedniej ilości danych da się to estymować).

Więc to jest "coś".

Portrecik naszego biednego, podatnego kleszcza: https://cdn.pixabay.com/photo/2021/01/17/19/27/tick-5926231_1280.jpg

Sama praca: https://www.pnas.org/doi/10.1073/pnas.2501045122

Artykuł bardziej popularny z ScienceDirect: https://www.sciencedaily.com/releases/2025/07/250704032922.htm

#kleszcze #nauka #ciekawostki #medycyna #biologia #bioinzynieria

Zaloguj się aby komentować

Dlaczego interesują nas pracowite bobry?

Dla Polaka to chyba, bóbr k⁎⁎wa, oczywiste. Są też inne podejścia, ja to prezentowane przez znanego włoskiego tenora, Enrico Palazzo.

Ale można też inaczej...

Dwa dni temu, drugiego lipca, udowodniono istnienie piątej liczby kroków w problemie pracowitego bobra. Wynosi ona 47,176,870. Tyle maksymalnie kroków wykona maszyna Turinga operująca na pięciu stanach wejściowych, zanim się zatrzyma (i jeśli się zatrzyma). Być może poznamy w przyszłości szóstą liczbę kroków, natomiast na siódmą są małe szanse (ilość kombinacji przyrasta lawinowo przekraczając możliwości jakiejkolwiek komputacji). Sama funkcja, do której stosują się te wartości, jest niepoliczalna. Co wiąże się wprost z problemem stopu sformułowanym przez Turinga - https://pl.wikipedia.org/wiki/Problem_stopu. No chyba, że znajdziemy jakieś prawo rozkładu tych wartości w inny sposób.

Artykuł popularny o tym odkryciu wraz z obszernym wyjaśnieniem - https://www.scientificamerican.com/article/new-math-breakthrough-reveals-the-fifth-busiest-beaver/

Strona projeku Busy Beaver Challenge z ogłoszeniem dowodu - https://discuss.bbchallenge.org/t/july-2nd-2024-we-have-proved-bb-5-47-176-870/237/1

Opis samej funkcji na polskiej wiki - https://pl.wikipedia.org/wiki/Pracowity_bóbr

#matematyka #ciekawostki #technologia #nauka

Zaloguj się aby komentować

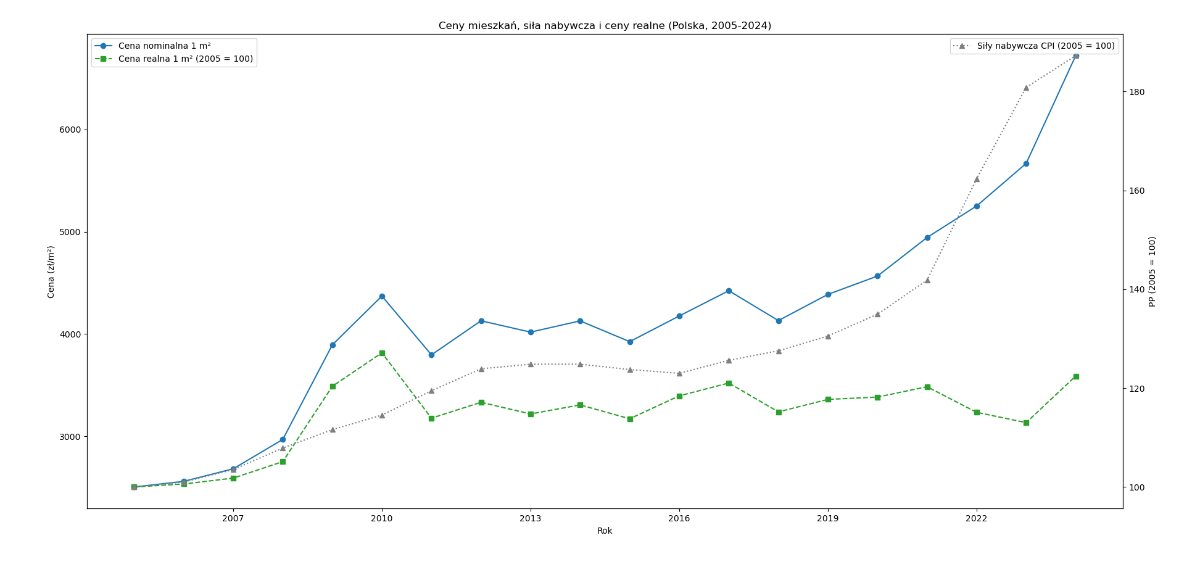

Skorygowane o CPI wskaźniki cen lokali mieszkalnych

Żal mi się zrobiło @bojowonastawionaowca, że chce czekać aż GUS wyprodukuje skorygowane dane (patrz wpis), a że miałem chwilkę i cały zestaw AI, żeby się ręcznie nie grzebać, no to poświęciłem te 15 minut i 30%

Więc sam je skorygowałem o CPI (z tych danych GUS), bazując na rocznych wskaźnikach, które skumulowałem. Ceny mieszkań za metr kwadratowy wziąłem z tych danych GUS.

Później tylko Python i matplotlib i voila.

Tutaj należałoby dalej pokorygować, ale 30% zobowiązuje.

#ciekawostki #nieruchomosci #polska #ciekawostkistatystyczne (sorki, że Ci na tag wchodzę

@Marchew Dzięki! Właśnie dlatego go zrobiłem, bo bez korekty dane wyglądają zupełnie inaczej i nie dają dobrego poglądu na stan rzeczy.

@ataxbras Te fluktuacje sięgają około +/- 10%. Na podstawie tego wykresu mogę odnieść wrażenie że wyczekiwanie "najtańszego okresu" na kupno własnego mieszkania to jakaś abstrakcja. Jeśli jest potrzeba, zdolność, fajna lokalizacja, dobry układ to się nie zastanawiać tylko kredycić.

Zaloguj się aby komentować

Ciemna materia, ciemna energia, generalnie ciemne sprawy, które kręcą nas najbardziej.

Pojawił się króciutki, 83 strony, raporcik badawczy: https://pole.uchicago.edu/public/data/camphuis25/C25.pdf

A tutaj jego bardziej popularny skrót: https://pursuit.unimelb.edu.au/articles/Growing-evidence-for-evolving-dark-energy-could-inspire-a-new-model-of-the-Universe

Chodzi generalnie o to, czy nasz Wszechświat skończy jako zimna, ciemna i martwa przestrzeń (śmierć termiczna), czy też będzie się rozszerzał wolniej i skończy tak samo, ale zajmie mu to dłużej (niestety, nie ma szans na Big Crunch, w każdym razie, nie w tym modelu) :D.

Wszystko zależy od oceny poziomu ciemnej energii i reszty tego naszego bałaganu. O bilans energetyczny.

Przeprowadzony eksperyment mierzący promieniowanie tła z niespotykaną dotąd dokładnością pokazał ogólną zgodność z modelem ΛCDM, a jednocześnie wskazuje na słabnięcie ciemnej energii. Albo czegokolwiek, co napędza ekspansję Wszechświata. Niezależnie od tego, dlaczego obserwujemy tą ekspansję i czy stoi za tym ciemna energia, czy też inne zjawisko (bo to wcale nie musi być ten czynnik - wspominałem o tym w tym wpisie: https://www.hejto.pl/wpis/https-www-youtube-com-watch-v-kfgwqicae8c-praca-naukowa-o-ktorej-mowi-sabine-jes), spowolnienie, jeśli potwierdzone, wydłuży czas potrzebny do całkowitej śmierci termicznej. Z 10^140 do 10^160. Cieszmy się zatem, te 20 dodatkowych zer to jest coś. Co więcej, rozpad protonów (jeśli możliwy) zajmie nie 10^34, tylko 10^36 (dwa zera więcej!!!). Więc jest się o co bić.

Czuje dobrze człowiek, jak coś takiego czyta.

#astronomia #kosmos #fizyka #nauka

@ataxbras jak to nie Big Cruch? ;( dla mojego chłopskiego rozumu to się wydawało najlogiczniejsze. Pulsujący wszechświat.

@onpanopticon Fajnie by było, ale na teraz wychodzi, że czeka naz zimno i halucynacje z niedożywienia. Też liczyłem na wielki show...

@ataxbras ale przecież będzie wielkie show - najpierw nasze słońce a potem Merge z Andromedą. Czy to już zostało odwołane? ( ͡° ʖ̯ ͡°)

Zaloguj się aby komentować

Wreszcie coś z mojej ulubionej dziedziny fizyki - i Waszej z pewnością też. A właściwie nie z fizyki, a z matematyki, ale bardzo konkretnie powiązane z dynamiką płynów (przez równania Naviera-Stokesa i Eulera).

Sabina, ta #niemraodfizy , przywołała tę pracę: https://arxiv.org/pdf/2503.01800 w swoim programie . Nazachwycała się nad nią okrutnie, poniekąd w dużej części słusznie.

Praca odnosi się do szóstego problemu Hilberta, dla tych, którzy nie pamiętają, chodzi o danie matematycznych podstaw aksjomatyki w fizyce. W szczególności zaś o opracowanie matematycznie rygorystycznego połączenia skal od mikro, przez mezo do obiektów makroskopowych. Nie daje rozwiązania całego problemu - jedynie jego części.

Rzeczywiście, pokazanie że modelowane prawa fizyki w różnych skalach mają ze sobą ścisły i przekładalny związek jest wielkim osiągnięciem. Jeśli ta praca zostanie zweryfikowana, to będzie można wyeliminować pokutujące w fizyce, powszechnie przyjęte domysły (poparte obserwacją) i zastąpić je pewnymi regułami (aksjomatyka).

Nie jest to jeszcze praca bez wad - jest ograniczona do 2 i 3 wymiarów, nie adresuje problemu płynów gęstych (Bolzmann tam nie pasuje), torus jest mało wygodnym sposobem obrazowania (topologicznie) i sporo innych. Ale jeśli jądro tej pracy jest poprawne, to reszta problemów jest rozwiązywalna.

Mnie, osobiście, brakuje tutaj związania kinematyki (Orr-Sommerfeld), a szczególnie opisu niestabilności (Burnett). Ale nie można mieć na raz wszystkiego.

#fizyka #matematyka #nauka #niemraodfizy

Acha, i robię streszczenie z Perplexity Labs, ale muszę je dobrze sprawdzić - pojawi się wtenczas w komentarzu. Robię to w ten sposób, bo czytać i trawić będę ją jeszcze co najmniej tydzień, by zdobyć jako takie pojęcie o użytych narzędziach. A skrót pewnie nie będzie strasznie zły.

Perplexity dało całkiem dobre podsumowanie, sam jestem w szoku. No ale ta gałąź matematyki nie jest nowa i jest sporo punktów odniesienia.

Szósty Problem Hilberta: Wyprowadzenie Równań Płynów za Pomocą Teorii Kinetycznej Boltzmanna

Ten przełomowy artykuł autorstwa Yu Denga, Zahera Haniego i Xiao Ma stanowi wielki przełom w fizyce matematycznej, twierdząc, że rozwiązuje kluczowy aspekt jednego z najbardziej wymagających problemów postawionych przez Davida Hilberta w 1900 roku. Praca ściśle wyprowadza fundamentalne równania mechaniki płynów bezpośrednio z praw Newtona rządzących mikroskopijnymi układami cząstek, kompletując to, co zostało nazwane "programem Hilberta" w teorii kinetycznej.

Kontekst Historyczny i Szósty Problem Hilberta

W 1900 roku David Hilbert przedstawił swoją słynną listę 23 problemów matematycznych, aby wyznaczyć kierunki badań w nowym stuleciu. Szósty problem wzywał do "aksjomatycznego traktowania fizyki" - konkretnie, matematycznych podstaw teorii fizycznych. Hilbert nakreślił dwa konkretne cele: po pierwsze, aksjomatyczne podstawy teorii prawdopodobieństwa (rozwiązane na początku XX wieku), a po drugie, rygorystyczne wyprowadzenie mechaniki kontinuum z teorii atomowej poprzez równania kinetyczne Boltzmanna.

Jak opisał to Hilbert, wyzwaniem było "matematyczne rozwinięcie procesów granicznych, tam jedynie wskazanych, które prowadzą od poglądu atomistycznego do praw ruchu kontinuów". Ten program wymagał połączenia trzech poziomów opisu:

Poziom Mikroskopowy: Prawa Newtona rządzące oddziaływaniami poszczególnych cząstek

Poziom Mezoskopowy: Równanie kinetyczne Boltzmanna opisujące statystyczne zachowanie cząstek

Poziom Makroskopowy: Równania mechaniki płynów (Eulera, Naviera-Stokesa) rządzące przepływem kontinuum

Wyprowadzenie obejmuje dwa krytyczne procesy graniczne:

Granica Boltzmanna-Grada (Newton do Boltzmanna)

Ten pierwszy krok wyprowadza równanie Boltzmanna z dynamiki cząstek typu twardych kul poprzez przyjęcie N → ∞ (liczba cząstek) i ε → 0 (średnica cząstki) przy zachowaniu relacji skalowania Nε^(d-1) = α stała, gdzie d jest wymiarem przestrzennym. To skalowanie, odkryte przez Grada, zapewnia, że cząstki oddziałują ze skończenie wieloma innymi na jednostkę czasu.

Granica Hydrodynamiczna (Boltzmann do Równań Płynów)

Drugi krok wyprowadza równania płynów z równania Boltzmanna poprzez przyjęcie współczynnika kolizji α → ∞, odpowiadającego drodze swobodnej zbliżającej się do zera.

Główną przeszkodą historyczną było ustanowienie pierwszej granicy dla długich czasów. Chociaż Lanford udowodnił wyprowadzenie dla krótkich czasów w 1975 roku, rozszerzenie tego na dowolne skale czasowe - niezbędne do połączenia z granicą hydrodynamiczną - pozostało nieuchwytne przez prawie 50 lat.

[ciąg dalszy w następnych komentarzach]

Główne Wyniki i Twierdzenia

Artykuł przedstawia trzy fundamentalne twierdzenia, które łącznie kończą program Hilberta:

Twierdzenie 1: Wyprowadzenie Równania Boltzmanna dla Długich Czasów

Opierając się na poprzednich pracach autorów, to twierdzenie rygorystycznie wyprowadza równanie Boltzmanna na obszarach periodycznych (2D i 3D tory) dla arbitralnie długich czasów, pod warunkiem istnienia rozwiązania Boltzmanna. Funkcja korelacji jednej cząstki f₁(t,x,v) zbiega do rozwiązania Boltzmanna n(t,x,v) z błędem ograniczonym przez ε^θ dla pewnej dodatniej stałej θ.

Twierdzenie 2: Wyprowadzenie Nieściśliwego Układu Naviera-Stokesa-Fouriera

Poprzez iterowany proces graniczny (najpierw granica Boltzmanna-Grada, potem granica hydrodynamiczna), to twierdzenie wyprowadza nieściśliwy układ Naviera-Stokesa-Fouriera z dynamiki cząstek typu twardych kul. Makroskopowe pola prędkości i gęstości wyłaniają się jako granice statystyczne empirycznych wielkości cząstkowych.

Twierdzenie 3: Wyprowadzenie Ściśliwego Równania Eulera

Podobnie, to twierdzenie wyprowadza ściśliwe równania Eulera rządzące gęstością, prędkością i temperaturą z tego samego mikroskopowego układu cząstek.

Innowacje Techniczne i Metody Matematyczne

Dowód wymaga wyrafinowanego aparatu matematycznego, z kilkoma kluczowymi innowacjami do radzenia sobie z ustawieniem periodycznym:

Chaos Molekularny i Funkcje Korelacji

Wyprowadzenie opiera się na kontrolowaniu s-cząstkowych funkcji korelacji fs(t), które mierzą zależność statystyczną między cząstkami. Hipoteza chaosu molekularnego (Stosszahlansatz) zakłada, że prędkości cząstek stają się nieskorelowane przed kolizjami, łamiąc symetrię odwrócenia czasu i umożliwiając wyłonienie się nieodwracalnego zachowania z odwracalnej dynamiki.

Nowe Wyzwania w Obszarach Periodycznych

Praca na torach zamiast w przestrzeni nieskończonej wprowadza fundamentalne komplikacje:

Podwójne Kolizje: W przeciwieństwie do przestrzeni nieskończonej, cząstki mogą zderzać się wielokrotnie z powodu periodyczności. Autorzy pokazują, że takie scenariusze wymagają prędkości względnych prawie równoległych do wektorów sieciowych, ograniczając je do zbiorów o mierze zerowej, które zapewniają wystarczające wzmocnienie objętości w oszacowaniach.

Nieograniczona Liczba Kolizji: Ustalona liczba cząstek może przechodzić arbitralnie wiele kolizji na torach, w przeciwieństwie do przypadku ograniczonego w przestrzeni euklidesowej. To wymagało całkowicie nowych podejść do kontrolowania prawdopodobieństw kolizji.

Długie Wiązania i Molekuły Elementarne

Kluczową innowacją jest koncepcja "długich wiązań" - zdarzeń kolizyjnych oddzielonych skalami czasowymi O(1) zamiast krótkich czasów kolizji O(ε). Autorzy pokazują, że molekuły zawierające długie wiązania mają znacznie poprawiony "nadmiar" (potęgi ε zyskane w oszacowaniach), co jest istotne dla zamknięcia analizy matematycznej.

Dowód wprowadza nowe klasy "molekuł elementarnych" (molekuły {333A}- i {334T}-) i wyrafinowane algorytmy cięcia do dekompozycji złożonych historii kolizji na zarządzalne komponenty.

Zaawansowana Analiza Kombinatoryczna

Techniczny rdzeń obejmuje skomplikowaną analizę kombinatoryczną "molekuł historii kolizji" - struktur grafowych reprezentujących sekwencje oddziaływań cząstek. Autorzy opracowują skomplikowane algorytmy cięcia, które systematycznie redukują złożone wzorce kolizji do przypadków elementarnych o znanych ograniczeniach.

[Koniec streszczenia]

Znaczenie Fizyczne i Matematyczne

Rozwiązanie Paradoksu Nieodwracalności Czasowej

Ta praca dostarcza rygorystyczne matematyczne wyjaśnienie tego, jak nieodwracalne zachowanie makroskopowe (opisane przez twierdzenie H Boltzmanna) wyłania się z odwracalnej mikroskopowej dynamiki Newtona. Ważność dla długich czasów obejmuje pełny czas życia rozwiązań Boltzmanna w pobliżu równowagi.

Kontrola Ilościowa

W przeciwieństwie do poprzednich wyników ograniczonych do krótkich czasów lub małych rozwiązań, ta praca dostarcza ilościowe ograniczenia ważne dla przedziałów czasowych o długości O((log|log ε|)^(1/2)). Chociaż to ograniczenie wynika z limitacji technicznych, reprezentuje duży postęp w stosunku do poprzednich wyników dla krótkich czasów.

Podstawa dla Zastosowań Inżynierskich

Matematyczne uzasadnienie równań płynów wzmacnia zaufanie do ich użycia w zastosowaniach inżynierskich od projektowania samolotów po przewidywanie pogody. Chociaż praktyczne równania pozostają niezmienione, ich rygorystyczne podstawy z pierwszych zasad reprezentują fundamentalny postęp w fizyce matematycznej.

Implikacje i Przyszłe Kierunki

Ten przełom otwiera kilka kierunków badawczych:

Wyższe Wymiary: Obecny dowód jest ograniczony do d ∈ {2,3}, ale metody mogą rozszerzyć się na wyższe wymiary z dodatkowym rozwojem technicznym

Inne Układy Fizyczne: Techniki mogą mieć zastosowanie do wyprowadzania innych teorii kontinuum z dynamiki mikroskopowej

Ulepszone Skale Czasowe: Przyszłe prace mogą rozszerzyć ważne przedziały czasowe poza obecne ograniczenia logarytmiczne

Praca demonstruje również moc łączenia zaawansowanych metod kombinatorycznych z klasyczną analizą w fizyce matematycznej, potencjalnie inspirując podobne podejścia do innych fundamentalnych problemów w tej dziedzinie.

Podsumowanie

Ten artykuł reprezentuje niezwykłe osiągnięcie w fizyce matematycznej, dostarczając pierwsze rygorystyczne wyprowadzenie fundamentalnych równań płynów z praw Newtona poprzez teorię kinetyczną Boltzmanna dla długich czasów. Przez ukończenie programu Hilberta w teorii kinetycznej, przerzuca mostek nad stuletnią luką między fizyką mikroskopową a makroskopową, oferując zarówno satysfakcję teoretyczną, jak i praktyczne zaufanie do podstaw matematycznych leżących u podstaw znacznej części nowoczesnej inżynierii i fizyki.

Wyrafinowane techniki matematyczne opracowane dla tego dowodu, szczególnie innowacyjne podejścia do radzenia sobie z periodycznymi warunkami brzegowymi i nieograniczonymi sekwencjami kolizji, reprezentują znaczące postępy metodologiczne, które mogą okazać się wartościowe przy ataku na inne wyzwaniowe problemy w fizyce matematycznej i teorii kinetycznej.

[ciąg dalszy w następnym komentarzu]

Zaloguj się aby komentować

Tym razem mam dla Was artykuł z mojej ulubionej serii o katastrofach lotniczych. Traktuje on tym razem o dwóch katastrofach, piersza jest dosyć znana - jej głównym bohaterem jest osa. O drugiej, przyznaję, nie słyszałem wcześniej.

Obie mają wspólny mianownik - błędny odczyt prędkości. O ile nie lata się balonem, czy helikopterem to prędkość postępowa jest jednym z kluczowych składników równania determinującego to, czy się leci, czy też spada. A wbrew pozorom, ustalenie wyniku tego równania nie jest proste.

W komentarzu umieszczę skrót po polsku, wyprodukowany przez Perplexity w wersji Labs. Sprawdziłem, jest OK, a poza tym jest znacznie krótszy, niż artykuł (choć artykuł zawiera wiele więcej ciekawych informacji).

Zdjęcie wzięte z artykułu, gdzie znajduje się atrybucja dla: Airlinerphotos.de via flickr.

#katastrofylotnicze #katastrofy #ciekawostki #technologia

Niebezpieczne Prawdy: Katastrofy Lotów Birgenair 301 i Aeroperú 603

Artykuł przedstawia analizę dwóch tragicznych katastrof lotniczych z 1996 roku, które na zawsze odmieniły oblicze współczesnego lotnictwa. Obie tragedię dotknęły samoloty Boeing 757 i wynikły z problemów związanych z nieprawidłowym pomiarem parametrów lotu, a w szczególności ich prędkości. Te wydarzenia stały się punktem zwrotnym w historii bezpieczeństwa lotniczego, zmuszając przemysł do gruntownej rewizji procedur szkoleniowych i systemów bezpieczeństwa.

Początek tragedii Birgenair 301

Szóstego lutego 1996 roku samolot linii Birgenair wystartował z dominikańskiego Puerto Plata, zabierając na pokład 189 osób w podróży do Berlina. Boeing 757 przez kilka poprzednich dni stał na płycie lotniska bez zabezpieczeń na rurkach pitota – delikatnych czujnikach odpowiedzialnych za pomiar prędkości względem powietrza. W tropikalnym klimacie Dominikany błotnice, miejscowe osy budujące gniazda z gliny, znalazły idealne miejsce na założenie kolonii w jednej z najważniejszych rurek pomiarowych samolotu.

Decyzja o starcie mimo problemów

Podczas procedur przedstartowych kapitan zauważył nieprawidłowe wskazania wskaźnika prędkości po swojej stronie kokpitu. Drugi pilot miał jednak prawidłowe odczyty ze swojego zestawu przyrządów. Załoga podjęła fatalne w skutkach postanowienie o kontynuowaniu lotu, nie zdając sobie sprawy z konsekwencji tego, że jeden z trzech systemów pomiaru prędkości został całkowicie wyłączony z działania przez osie gniazdo.

Pułapka systemów automatycznych

Po włączeniu autopilota sytuacja przybrała dramatyczny obrót. System automatycznego sterowania korzystał głównie z danych pochodzących z zablokowanej rurki pitota kapitana. Te błędne informacje wskazywały na stale rosnącą prędkość, proporcjonalną do wysokości lotu. Autopilot, "przekonany" o konieczności zmniejszenia prędkości, systematycznie zwiększał kąt wznoszenia samolotu, co w rzeczywistości powodowało niebezpieczne zmniejszanie rzeczywistej prędkości lotu.

Zagadkowe ostrzeżenia systemowe

W kokpicie zaczęły pojawiać się tajemnicze komunikaty ostrzegawcze: "rudder ratio" oraz "mach/speed trim". Dla załogi były to całkowicie niezrozumiałe sygnały, ponieważ w owym czasie piloci nie otrzymywali żadnego szkolenia dotyczącego problemów z nieprzetworzonymi danymi o prędkości powietrza. Producenci samolotów zakładali błędnie, że doświadczeni piloci instynktownie poradzą sobie z takimi anomaliami.

Śmiertelny korkociąg nad Atlantykiem

Gdy załoga przełączyła autopilot w tryb sterowania pionowego, system jeszcze bardziej zwiększył kąt natarcia i zmniejszył ciąg silników, dążąc do osiągnięcia pozornie wysokiej prędkości 350 węzłów. Samolot wszedł w przeciągnięcie, po czym w niekontrolowany korkociąg i runął do wód Atlantyku. Wszyscy pasażerowie i członkowie załogi stracili życie. Kluczową przyczyną tragedii okazał się brak zrozumienia, w jaki sposób błędne dane z czujników wpływają na zachowanie nowoczesnych systemów automatycznych.

Ciąg dalszy w następnym komentarzu.

Druga tragedia - lot Aeroperú 603

Osiem miesięcy później, drugiego października 1996 roku, nastąpiła kolejna katastrofa o podobnej genezie. Samolot linii Aeroperú wystartował z peruwiańskiej Limy w kierunku chilijskiego Santiago, przewożąc 70 osób. Dzień wcześniej technicy, podczas czyszczenia kadłuba po zderzeniu z ptakiem, przykleili srebrną taśmę na porty statyczne – czujniki ciśnienia atmosferycznego. Ta pozornie niewinna czynność miała tragiczne konsekwencje.

Błąd komunikacyjny na ziemi

Taśma miała zostać usunięta przed następnym lotem, jednak błąd w komunikacji między różnymi zespołami konserwacyjnymi sprawił, że pozostała na swoim miejscu. Jej srebrny kolor niemal idealnie wtapiał się w barwę kadłuba, co dodatkowo utrudniało jej zauważenie podczas kontroli przedlotowej. Ten pozornie drobny szczegół techniczny doprowadził do całkowitego zakłócenia systemów pomiaru parametrów lotu.

Chaos w kokpicie nad Pacyfikiem

Zablokowane porty statyczne wywołały prawdziwy chaos wśród przyrządów pokładowych. Wysokościomierze "zamarzły" na poziomie lotniska startowego, podczas gdy system ostrzegał przed niebezpiecznymi zmianami prędkości wiatru. W miarę wznoszenia się samolotu wskazania stawały się coraz bardziej mylące i wzajemnie sprzeczne. Wysokościomierze pokazywały za niskie wartości, prędkościomierze zaś dawały błędne odczyty w zależności od fazy lotu.

Paradoks jednoczesnych alarmów

Szczególnie dramatyczna była sytuacja, gdy jednocześnie włączyły się alarmy ostrzegające przed przekroczeniem dopuszczalnej prędkości oraz przed groźbą przeciągnięcia – dwa fizycznie niemożliwe do jednoczesnego wystąpienia stany lotu. Ta sprzeczność powinna była być sygnałem ostrzegawczym, jednak załoga nie miała odpowiedniego przygotowania do interpretacji tak skomplikowanej sytuacji awaryjnej.

Fałszywe poczucie bezpieczeństwa

Kluczowym błędem okazało się zaufanie do kontrolerów ruchu lotniczego, którzy "potwierdzali" parametry lotu na podstawie radaru wtórnego. Piloci nie zdawali sobie sprawy, że informacje o wysokości przekazywane do centrum kontroli pochodzą bezpośrednio z pokładowych systemów samolotu – tych samych, które już zostały uznane za niesprawne. To błędne koło wzajemnego potwierdzania utwierdzało załogę w przekonaniu o częściowej sprawności przyrządów.

Tragiczny finał nad oceanem

Po niemal trzydziestu minutach desperackiej walki z chaotycznymi wskazaniami, samolot znajdował się w rzeczywistości zaledwie kilkaset stóp nad powierzchnią Pacyfiku, choć wysokościomierze wskazywały prawie dziesięć tysięcy stóp. System ostrzegania przed zderzeniem z ziemią działał prawidłowo i alarmował o śmiertelnym niebezpieczeństwie, ale piloci, przekonani o błędności tego ostrzeżenia, zignorowali ostatnią szansę na uratowanie lotu. Lewa końcówka skrzydła uderzyła w wodę, samolot przechylił się i runął do oceanu.

Rewolucja w bezpieczeństwie lotniczym

Te dwie katastrofy stały się katalizatorem bezprecedensowej rewolucji w lotnictwie cywilnym. Wprowadzono obowiązkowe szkolenia dotyczące scenariuszy nieprawidłowych wskazań prędkości, opracowano procedury pamięciowe oparte na zasadzie "najpierw ustabilizuj parametry lotu, potem rozwiązuj problem", a także zaawansowane systemy automatycznego wykrywania błędnych danych czujników. Współczesne samoloty wyposażone są w inteligentne systemy porównujące dane z różnych źródeł, w tym GPS, i automatycznie wykluczające nieprawidłowe informacje. Dzisiejsi piloci przechodzą intensywne szkolenia symulatorowe, uczące ich radzenia sobie z sytuacjami, które w 1996 roku były praktycznie nieznane instruktorom lotniczym.

Zaloguj się aby komentować

https://www.youtube.com/watch?v=LWzK6nITCK0

Jakoś nie jestem zdziwiony, że Sabina, ta #niemraodfizy, nakręciła się konkretnie (negatywnie) na pracę, którą niedawno (w tym wpisie) Wam prezentowałem.

I Sabina ma sporo racji, choć nie do końca. To będzie wyłącznie moja opinia, jak zwykle zresztą.

To prawda, że właściwie każdy kogo fizyka zaczyna kręcić, zauważa że wymiar czasowy "odstaje" od przestrzennych. I zaczyna szukać bardziej eleganckiego dlań opisu (nie chodzi jednak tylko o symetrię 3:3).

Co do funkcji falowej już nie do końca ma rację, bo niewypowiedzianie przyjmuje założenie, że wymiary czasowe i przestrzenne są niezależne. Autor pracy właśnie na tym buduje swój framework, że są one zależne. Wtenczas, zaproponowana normalizacja może mieć sens, bo wspiera przekładalność i symetrię tych dwóch grup wymiarów. Dalej, Sabina wywodzi wnioski ze swoich założeń.

Nie, żebym bronił autora pierwotnego artykułu, musiałbym się wtedy pokusić o dogłębną jego analizę.

Niemniej, poszukiwania alternatywnej interpretacji wymiarów czasowych mają sens i nie są rzadkością. To nie jest tak, że z pewnością jest tylko jeden, laminarny i niezmienny. Może tak być, ale nie ma jednoznacznych dowodów, że tak jest (wiem, brzmi to dziwnie). W przeciwnym wypadku, nie byłoby tego typu poszukiwań (jak choćby te przeze mnie wspomniane - Dragana). Z czasem jest coś nie tak, jest wymiarem nie pasującym do całości, właściwością wszechświata bez większego sensu poza sprzężeniem z entropią (a i tu jest to sprzężenie "niekonsekwentne").

Jednak dla pełni obrazu wstawiam Sabinę, bo warto znać jej pogląd (a za stałość jej poglądów ją cenię).

#fizyka #nauka #fizykakwantowa #niemraodfizy

Zaloguj się aby komentować

https://www.sciencenews.org/article/magic-error-quantum-computing

Trochę magii na dziś.

To dosyć popularny, lub też popularyzatorski artykuł. Mówi on o tym, że tak zwane „magiczne stany” to klucz do stworzenia odpornego na błędy komputera kwantowego. Większość stanów kwantowych błyskawicznie poddaje się hałasowi i traci informacje, a bez nich nie można wykonywać obliczeń. „Magiczne stany” są jednak na tyle stabilne, że pozwalają na odporne na błędy operacje, nawet gdy środowisko robi się zbyt hałaśliwe. Dzięki nowym osiągnięciom w dziedzinie stanów magicznych, można wykonywać bardziej złożone obliczenia, bez konieczności zużywania całych stert dodatkowych qubitów.

A czym właściwie są te magiczne stany? I tu miałem małą zagwozdkę, jak to wytłumaczyć. Bo to dosyć prosty i podstawowy koncept (koncept, nie realizacja), ale wymaga jakiejś wiedzy na temat bramek kwantowych.

Ale spróbujmy. W przypadku komputerów kwantowych mamy dwa typy bramek. Bramki w sensie Clifforda, i bramki wyłącznie kwantowe (nieCliffordowe). O co chodzi? Pierwsze są symulowalne wydajnie na komputerach klasycznych. Czyli nie dają zysku z używania komputera kwantowego. Drugie zaś, nie są łatwo symulowalne i nie da się ich w prosty sposób użyć w systemach z korekcją błędów. Obejściem tutaj jest właśnie użycie tych magicznych stanów, które dają bazę/punkt odniesienia konieczny do tworzenia surogatów bramek nieCliffordowych przy pomocy bramek Cliffordowych. Ten punkt odniesienia to precyzyjnie spreparowany stan kwantowy. A dalej jest jeszcze destylacja stanów magicznych, żeby ograniczyć poziom szumów.

Pewnie moje tłumaczenie i tak nie wyszło zbyt klarowne, ale postarałem się na całe 30%

#fizyka #matematyka #technologia #nauka

błyskawicznie poddaje się hałasowi

Jeśli idzie o 'noise' to tłumaczy się, jako 'szum', a nie 'hałas'.

@Fly_agaric Nie mogę już edytować, ale masz rację. I to kawałek, w którym pomogłem sobie AI, a miałem go nie wklejać

Ja piernicze - nic nie rozumiem ale mi się to dobrze czyta.)*

Ignorant ze mnie.

)* - ale to żaden powód do chwały że niby wiem że nic nie wiem więc ... jestem lepszy bo chociaż o tym wiem. Po prostu - ignorant ze mnie. Bez podtekstu.

@w0jmar Ja też nie. Zawsze się pocieszam wtedy cytatem z Feynmana

„ktokolwiek mówi, że rozumie mechanikę kwantową ten, albo kłamie, albo jest szalony.”

@onpanopticon Ten cytat to tak nie do końca, Feynmann powiedział: "I think I can safely say that nobody really understands quantum mechanics". Reszta to czyjeś twórcze rozszerzenie.

I z pewnością do końca nikt jej nie rozumie, bo jest ona nieintuicyjna. Nie mamy właściwego punktu odniesienia do świata kwantowego, mimo że w nim żyjemy. Ale obserwujemy jedynie statystyczną wypadkową tego świata, która jest dużo bardziej regularna.

Zaloguj się aby komentować

https://journals.aps.org/prx/abstract/10.1103/PhysRevX.12.021061

Chcecie nowych radarów, systemów namierzania, trudniejszej do zakłócenia transmisji w komponencie magnetycznym? No a poza tym, paru innych rzeczy z cywilnej elektroniki, ale to mało interesujące.

No to jest nowinka, która na to pozwoli. Metoda polega na tym, że kwantowy czujnik robi za mixer – miksuje sygnały o różnych częstotliwościach i przerzuca je w rejony, które umie dobrze zmierzyć. Sprawdzono to na defektach azotu w diamentach, gdzie udało się wykryć magnetyczny sygnał o częstotliwości 150 MHz, czyli zupełnie poza zwykłym zasięgiem czujnika. Całość opiera się na efektach Floqueta (https://encyclopediaofmath.org/wiki/Floquet_theory), które bazują na nieliniowości, pozwalające na miksowanie kwantowe sygnałów, a dodatkowo metoda pozwala też ogarnąć wektorową budowę pola (kierunkowość), nie tylko jego siłę.

#fizyka #nauka #technologia

Jest jeszcze przystępniejszy artykuł na MIT: https://news.mit.edu/2022/quantum-sensor-frequency-0621

@ataxbras kiedy dotrą moje filtry antyentropiczne i kwantowe stabilizatory pola dziwennego ja się pytam!?

@AdelbertVonBimberstein Kurde, już poszły, z tym że wygląda na to, że w przestrzeni mocno nie deSitterowskiej. Więc mogą dotrzeć niedługo, albo za 10^12 lat. Wypatruj kuriera!

Zaloguj się aby komentować

https://www.youtube.com/watch?v=KFgwQICae8c

Praca naukowa, o której mówi Sabine jest rzeczywiście dosyć intrygująca. To dopiero wczesny preview: https://www.sciencedirect.com/science/article/pii/S0550321325001403 .

W zasadzie, jeśli to się spina, a wygląda na to że tak, to sporo kosmologii i fizyki z nią związanej trzeba będzie solidnie przemyśleć.

Okazuje się, że formowanie się wielkich galaktyk na samym początku wszechświata to nie tylko domniemanie, ale fakt, który konkretnie namieszał w obserwacjach mikrofalowego tła kosmicznego. Te ETG (early-type galaxies, galaktyki wczesnego typu) powstały błyskawicznie i bardzo wcześnie, tak gdzieś przy czerwonym przesunięciu 15-20 (200 - 350mln lat po Wielkim Wybuchu), czyli kiedy wszechświat dopiero praktycznie raczkował. Cała ta szybka akcja formowania masywnych gwiazd i chemiczne wzbogacenie otoczenia sprawia, że sygnał CMB (cosmic microwave radiation - mikrofalowego promieniowania tła), za którym tak wszyscy przepadają, jest trochę „zabrudzony” przez te giganty. Najciekawsze jest to, że według szacunków ich wpływ sięga od kilku do nawet stu procent energii mikrofalowego tła. I tu jest właśnie to "WOW". Bo jeśli to prawda, to stawia to pod znakiem zapytania model ΛCDM, bo może być tak, że przed formacją tych galaktyk żadne promieniowanie nie zostało wyemitowane, lub zostało w niewielkim stopniu. A to by oznaczało, że nie było epoki ciemnej i gęstej, że jakiś inny mechanizm kształtował wszechświat w jego początkach. Co jest co najmniej dziwne.

#kosmos #fizyka #ciekawostki #nauka #niemraodfizy

Zaloguj się aby komentować

Fizyka teoretyczna - wiem, że Was to kręci, tak jak mnie.

Mam tutaj dwa linki, jeden do opisu pracy językiem w miarę przystępnym i drugi do samej pracy.

No więc pierwszy to: https://phys.org/news/2025-06-theory-dimensions-space-secondary-effect.html

Artykuł traktuje o nowym podejściu do kwestii wymiarów czasoprzestrzennych. Okazuje się, że przy założeniu istnienia trzech wymiarów czasowych i trzech przestrzennych będących koniecznym ze względu na symetrię rezultatem istnienia pierwszych, sporo rzeczy zaczyna się spinać. Jak dalece? Autor oryginalnej pracy proponuje weryfikację eksperymentalną, choć na mój nos propozycja daje duże pole do interpretacji.

Dalej, według pracy, z perspektywy nadświetlnego obserwatora to właśnie czas rozkłada się na trzy niezależne osie, podczas gdy przestrzeń robi za słabe echo. To zresztą ciekawie tłumaczy zjawiska kwantowe, jakby cząstka się starzała w trzech różnych czasach, a my widzimy to jako ruch w przestrzeni. Zasada Huygensa w nowym wydaniu? Może.

To nie jest bardzo nowy pomysł z perspektywy ogólnych założeń, ale bez wątpienia nowatorski jeśli chodzi o detale.

Andrzej Dragan również poszukuje podobnej symetrii, z tym że przy założeniu odbicia przy obserwatorach nadświetlnych (trzy wymiary czasowe i jeden przestrzenny przy V>c).

Link do samej pracy: https://www.worldscientific.com/doi/10.1142/S2424942425500045 . Na pierwszy rzut oka wygląda dosyć solidnie, poczytam sobie wieczorem dokładniej.

#fizyka #nauka #fizykakwantowa

Zaloguj się aby komentować

Piszą o nas, Poland stronk!

Ale bez podniety, jesteśmy tylko zaznaczeni na mapce, jako kraj przykładający dużą wagę do tematu AI w edukacji

Też się zdziwiłem.

Ale do rzeczy. University of Georgia (chciałem to przetłumaczyć, ale Uniwersytet Dżordżii wygląda dziwnie, Georgii też, więc zostawiłem) przeprowadził badanie (bo amerykańscy naukowcy ciągle coś badają) i wyszło im, że świat w różnym stopniu przygotowuje się na nową rzeczywistość wypełnioną AI i robotyzacją i USA nie jest w czołówce tych przygotowań.

Artykuł traktuje zaś o tym, że w Stanach Zjednoczonych AI w edukacji właśnie weszło na wyższy level – rząd postanowił, że sztuczna inteligencja ma być traktowana poważnie już od przedszkola. Najważniejsze są teraz programy nauczania AI w szkołach, szkolenia dla nauczycieli oraz ogólnokrajowe konkursy dla młodych talentów, które mają rozkręcić temat. Do tego dochodzą partnerstwa publiczno-prywatne i wsparcie finansowe z grantów, żeby nikt nie został w tyle.

Brzmi ciekawie, jeszcze ciekawszym jest, jak będzie wyglądać realizacja. Pożyjemy, zobaczymy.

#sztucznainteligencja #wiadomosciswiat #ciekawostki #technologia

Kolejny przykład na to, że politycy czują, że muszą jakoś na ten nowy dynamicznie się rozwijający trend reagować, ale nie bardzo wiedzą jak.

To jest zwykłe bicie piany.

na politechnice warszawskiej działa pewna grupa o dystopijnej nazwie

grupa do spraw bezpiecznej absorpcji AI ಠ_ಠ

kraj przykładający dużą wagę do tematu AI w edukacji

@ataxbras WOT? Niby gdzie xD AI i polska edukacja mają się do siebie mniej więcej tak jak pięć do nosa, bo polskie szkoły się bronią jak mogą, żeby tylko dzieciaki nie uczyły się niczego co jest nowsze jak 200 lat xD

Zaloguj się aby komentować

https://journals.plos.org/ploscompbiol/article?id=10.1371%2Fjournal.pcbi.1012814

Znalazłem dosyć ciekawą pracę naukową - Mechanizmy nieufności: bayesowskie ujęcie uczenia się dezinformacji.

Dotyczy ona ogólnego wzorca podchodzenia ludzi do pozyskiwania informacji i ograniczeń umiejętności odfiltrowywania dezinformacji. To o tyle interesujące dla mnie osobiście, bo mam do czynienia z zagadnieniem wykrywania zatruwania źródeł informacji, takie hobby. A że zarówno ludzie, jak i maszyny podążają w tej kwestii podobnymi ścieżkami, szczegółowe obserwacje jednej z tych grup dają wgląd w to, jak to może wyglądać w drugiej (stąd tag #sztucznainteligencja - bo mimo wszystko, jest to powiązane). Szczególnie, że mechanizmy bayesowskie powinny się pokrywać, bo nasza rzeczywistość to łańcuchy w sensie Markowa. Wiem, brzmi to jak bełkot, ale jeśli ktoś jest ciekawy to mogę wyjaśnić. Na szybko, tutaj artykulik z perspektywy wnioskowania statystycznego: https://csc.ucdavis.edu/~cmg/papers/imc.pdf.

A wracając do artykułu, badanie w nim przedstawione pokazuje, jak mózg radzi sobie z nauką o tym, czy informacje są godne zaufania, podążając za modelem bayesowskim. Uczestnicy eksperymentu musieli rozróżnić różne rodzaje źródeł informacji – od szczerych po zmanipulowane – a ich reakcje pasowały do teoretycznych założeń modelu. Co ciekawe, wszyscy startowali z domyślnym przekonaniem, że źródła są pomocne, co jest trochę jak dawanie kredytu zaufania, zanim padnie pierwsza wątpliwość. Kiedy jednak dane były bardziej zaszumione, trudniej było zauważyć, kto próbuje manipulować. No i to jest właściwie clue samego badania - wykazanie istnienia i stopnia tej zależności.

#spoleczenstwo #dezinformacja #nauka #sztucznainteligencja

Zaloguj się aby komentować

https://phys.org/news/2025-06-uranium-enrichment-nuclear-scientist.html

Wzbogacanie uranu to temat teraz na topie, szczególnie że Iran sobie chwilowo nie powzbogaca dzięki paru tonom demokracji, które właśnie na niego spadły.

Na zachętę wybrałem dosyć przystępny i krótki artykuł, w sam raz na ciekawostkę, nie zaś na dogłębną analizę tematu.

W skrócie - uran to pierwiastek, który ma dwa główne typy izotopów — 238 i ten, który naprawdę nas interesuje, 235. Ten drugi jest kluczem do tworzenia broni atomowej (ale też i przede wszystkim paliwem energetyki jądrowej), bo to właśnie jego koncentracja decyduje o możliwościach materiału rozszczepialnego. Wzbogacanie to proces oddzielania tych izotopów, żeby podbić udział 235 do poziomu odpowiedniego do bomb lub reaktorów. Sposobów jest kilka, ale najpopularniejsze to wirówki gazowe, które wyciskają 235 z mieszaniny dzięki różnicy mas. Cała ta zabawa jest w zasadzie prymitywna, jednak w szczegółach zaawansowana technologicznie i kosztowna.

#iran #uran #ciekawostki #technologia

@ataxbras offtop troche - https://youtu.be/jV2kj7lpGyw?si=2wPsOXl6uM8SdvNI

Zaloguj się aby komentować

Teoremat Nernsta... Brzmi groźnie, ale w rzeczywistości chodzi o to, czy Passat Waszego starego może wykorzystać całą energię z LPG w zdrutowanej instalacji gazowej. I odpowiedź właśnie się pojawiła! Mógłby, ale to niepraktyczne, bo przy temperaturze zera bezwzględnego, Wasz stary mógłby zmarznąć.

Pojawił się właśnie dowód teorematu Nersta, który w skrócie potwierdza istnienie T0 (zera bezwzględnego) jako rzeczywistego punktu odniesienia w sensie termodynamicznym. Potwierdza też bezpośredni związek pomiędzy drugą i trzecią zasadą termodynamiki.

Passaty jednak dalej będą dymić.

Jak kto ciekaw detali, to niech pyta.

Daję dwa linki, pierwszy to wersja popularna:

https://thedebrief.org/new-solution-to-120-year-old-absolute-zero-problem-shows-einstein-was-wrong/

a drugi to sam dowód:

https://link.springer.com/article/10.1140/epjp/s13360-025-06503-w

#fizyka #termodynamika #nauka #zeroabsolutne

Zaloguj się aby komentować

https://phys.org/news/2025-06-physicists-3d-spines-sculpt-surface.html

Niby to jeszcze nie woda płynąca pod górę, ale już blisko. Wrzucam to, bo ładne (no i mam fazę na phys.org). Zobaczcie dołączone wideo.

Fizycy z Uniwersytetu w Liège wykorzystali drukowane w 3D stożkowe kolce, by „rzeźbić” powierzchnię wody, tworząc programowalne krajobrazy z cieczy zdolne do manipulowania cząstkami wyłącznie za pomocą grawitacji. Kolce, rozmieszczone gęsto na powierzchni, generują meniski, które sumują się w skali makro, tworząc nachylenia, czy doliny. Dzięki temu cząstki o różnej gęstości samoistnie przemieszczają się po „autostradach” z wody – lżejsze unoszą się, a cięższe suną w dół niczym po zboczu góry. Technika, oparta na zjawisku napięcia powierzchniowego, może znaleźć zastosowanie w mikrotransportie, sortowaniu cząstek czy usuwaniu mikroplastików z powierzchni wody.

#fizyka #inżynieria #nanotechnologia #nauka

Zaloguj się aby komentować