W średnim segmencie kart graficznych panuje dramat a za niedługo zapanuje jeszcze większy.

Własciwie to ten segment zniknie.

Patrząc na AMD

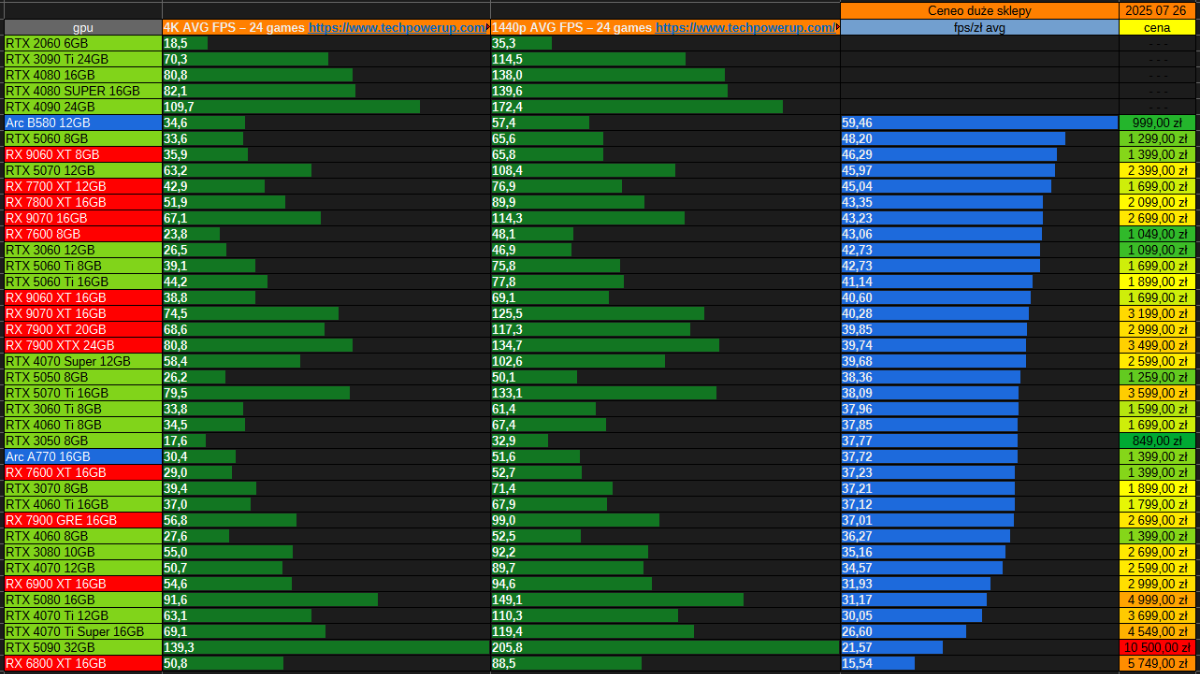

Mamy karty 9070 i 9070 XT obie to obecne odpowiedniki segmentu wysokiego czyli 7900 XT i 7900 xtx. Nowe karty kosztują odpowiednio 3000zl i 3400zl.

Planowany 9600 XT według przecieków ma być w dwóch wariantach 8gb i 16gb vram czyli tak jak obecny wariant 7600 i 7600 XT.

W generacji 7000 mieliśmy de facto 3 modele kart 7600, 7800 i 7900 - modele pośrednie bazowały na nich i z reguły były nieopłacalne przykładowo 7700 XT był długo nieopłacalny względem 7800 XT.

W nowej generacji brak jest tego średniego segmentu, reprezentującego obecny 7700 XT i 7800 XT.

Nawet jeśli 9060 XT będzie miał moc 7700 XT to model 8 GB będzie miał za mało vram względnem tej mocy a 16gb będzie miał za vram względem mocy i strzelam że będzie za drogi. Czyli identycznie jak chociażby w przypadku modeli rtx 4060, rtx 4060 ti i rtx 3060 12gb.

Zatem według mnie za niedługo AMD wstrzyma produkcję serii 7000 oprócz modelu 7600 ten model uchowa się jak obecny 6600 ze względu na tańszy proces produkcji - czyli w sumie tak jak mniej więcej było z serią 6000. Zostaną tanie karty do gry w 1080p z 8gb vram przykładowo 9060 z 8gb vram za 1500zl

lub drogie do gry w 1440p-4k przykładowo RX 9070 za 2500zl. Po środku będzie 9060 z 16gb za 2000zl stanowiący nieopłacalna konstrukcje. W przypadku nvidii będzie podobnie, tylko drożej.

Krótko mówiąc, za jakiś czas karty które do pewnych zastosowań (np 1440p średnio wysokie) są w sam raz jak RX 7700 XT i RX 7800 XT znikną, a w ich miejscu nie będzie nic. Jak ktoś ma budżet w okolicy 2000 zł na kartę graficzną to nie ma według mnie na co czekać.

#pcmasterrace #kartygraficzne #komputery #gry