#wiadomosciswiat #ai

Czyżby znów Chiny szykowały nam jakieś potężne przetasowanie w świecie "AI", czy tylko marketingowe bicie piany? Brzmi to baardzo mocno. No i znów otworzyli źródła!

DeepSeek to dopiero początek. Chiny już mają nowego króla AI

Ledwie opadł kurz po wstrząsie, jaki DeepSeek zaserwował Dolinie Krzemowej, a już Chiny informują o modelu AI, który idzie dalej – jest tańszy, szybszy i „bystrzejszy”.

...

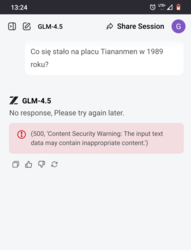

Czym jest model GLM-4.5 start-upu Z.ai?

Startup Z.ai (dawniej Zhipu) poinformował, że jego nowy model GLM-4.5 będzie jeszcze tańszy w eksploatacji niż DeepSeek. Twierdzi, że w przeciwieństwie do dotychczasowych rozwiązań, jego model opiera się na tzw. „agentowej” AI, która automatycznie dzieli zadania na podzadania, by wykonać je dokładniej. Model został udostępniony jako open source, co oznacza, że programiści mogą go pobrać i używać za darmo.

Model GLM-4.5 ma około połowę rozmiaru DeepSeeka i do działania potrzebuje tylko ośmiu chipów Nvidia H20, specjalnej wersji chipu stworzonej z myślą o rynku chińskim, zgodnie z ograniczeniami eksportowymi USA. Nvidia ogłosiła w lipcu, że może wznowić sprzedaż tych chipów do Chin po trzymiesięcznej przerwie.