#programowanie #aws

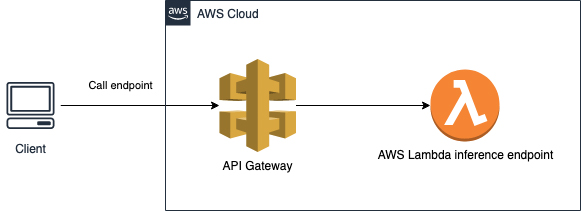

Mam sobie taką lambdę która jest mocno używana, ale jej cold start zajmuje 50s, przez co api gateway nie pozwala go wykonać (bo wywala timeout po 30s, i nie moge go zmienić z tego co czytałem).

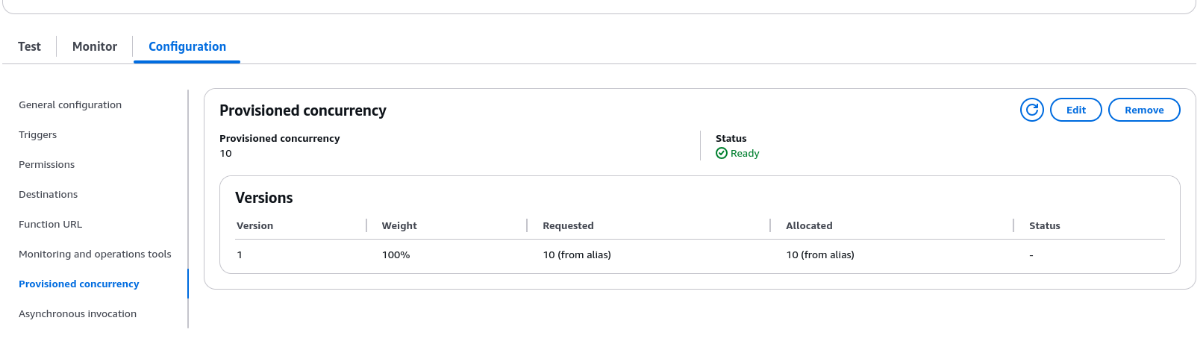

W związku z tym, chciałem jej dać provisioned concurrency, żeby zawsze była aktywna.

Czy wg tej konfiguracji, ta funkcja będzie aktywna 24/7 i może ogarnąć do 10 requestów naraz?

Wg. kalkulatora to ma kosztować prawie 150$ na miesiąc więc to zmniejszyłem do 1, ale pytam czy dobrze rozumiem co robie XD