Tak jak informowałem wcześniej, przygotowałem coś fajnego, czym pragnę się podzielić, z dziedziny #IT (czyli #informatyka czy tam #komputery).

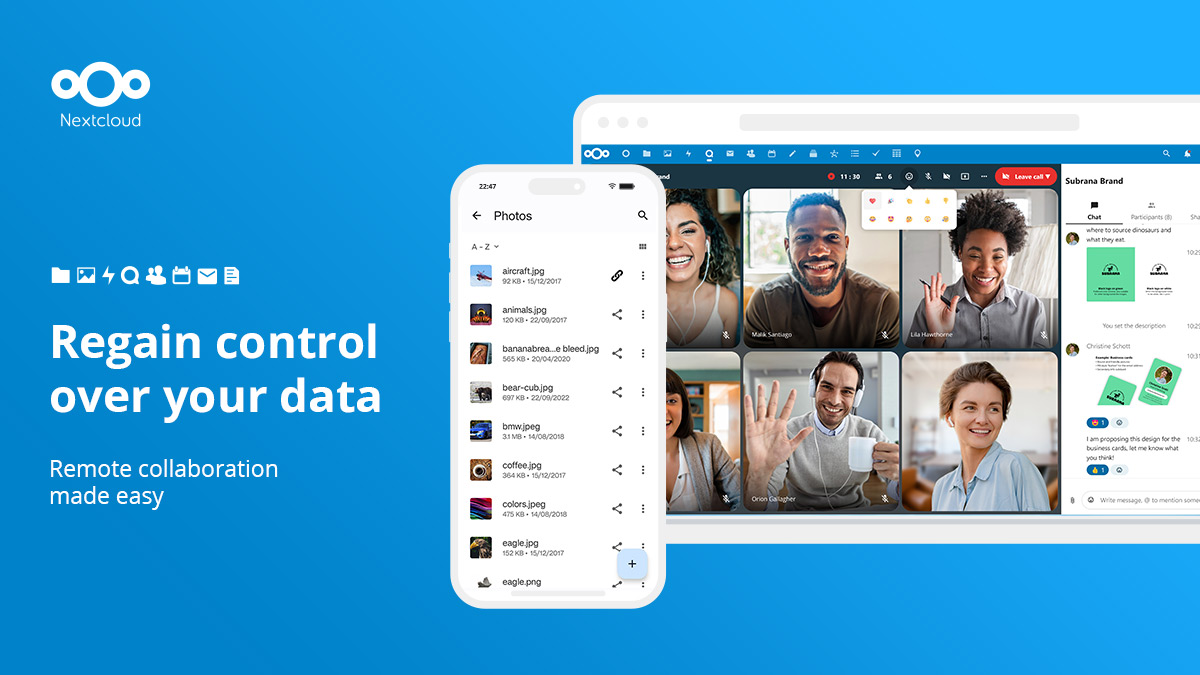

Dzisiejszym tematem jest #Nextcloud czyli darmowy, otwartoźródłowy silnik chmury plikowej, który ma wsparcie dla języka polskiego. Można by powiedzieć, że jest to darmowy odpowiednik usług takich jak OneDrive, Google Drive czy Dropbox. Różnica polega na tym, iż to jest nasz własny serwer plików, prywatny, którego limit przestrzeni jest taki, jak wolna pamięć na dysku.

Strona samego projektu: https://nextcloud.com/

Jak to zwykle w wypadku systemu #Linux bywa, uruchomienie tego na własną rękę (szczególnie za pierwszym razem) może być trudne, dlatego przygotowałem skrypt, działający w systemie #Debian Linux w wersji 11. Upraszcza on prawie do zera operacje, które należy wykonać. Wystarczy mieć gotowy komputer z zainstalowanym systemem (wspomnianym już Debianem 11). Może to być także maszyna wirtualna. W systemie nie musi być wcześniej nic zainstalowane, wykonane (zalecam czysty system). Wystarczy jedna komenda:

sudo sh -c "wget -q https://github.com/nicrame/Linux-Scripts/raw/master/nextcloud-debian-ins.sh && chmod +x nextcloud-debian-ins.sh && ./nextcloud-debian-ins.sh"

Po jej wykonaniu z poziomu terminala (lokalnie czy zdalnie po SSH), zostaną zainstalowane i wstępnie skonfigurowane wszystkie wymagane podprogramy (serwer WWW Apache z PHP, baza danych MariaDB, i inne wymagane elementy jak redis czy ntp). Na koniec wykonywania skrypt poda dane logowania z wygenerowanym losowo hasłem (trzeba je zachować, ponieważ nie jest ono nigdzie zapisywane). No i można korzystać.

Dla bardziej zaawansowanych użytkowników, którzy chcieli by aby ich dysk sieciowy działał także z sieci Internet (i mają już przygotowaną domenę, oraz skonfigurowany router w odpowiedni sposób) można uruchomić instalator z argumentem domeny:

sudo sh -c "wget -q https://github.com/nicrame/Linux-Scripts/raw/master/nextcloud-debian-ins.sh && chmod +x nextcloud-debian-ins.sh && ./nextcloud-debian-ins.sh mojadomena.com"

Dodatkowo zostaną wprowadzone ustawienia umożliwiające użycie domeny.

Sam producent co prawda udostępnia swoje rozwiązanie instalujące Nextcloud w systemie Linux, ale jest ono oparte na Dockerze, a więc dodatkowej warstwie (środowisku) oddzielającej skrypt i wymagane do jego działania programy od głównego systemu. Kosztem tego jest jednak trudność w zarządzaniu wszystkim (np zmiana wybranych elementów w późniejszym czasie) czy też diagnostyka i rozwiązywanie ewentualnych problemów. No i każda dodatkowa warstwa to większe obciążenie dla systemu.